Google Search Console to podstawowe narzędzie każdego specjalisty SEO, lecz korzystać z niego mogą – i powinni – również właściciele stron internetowych czy specjaliści od marketingu, którzy chcą wyżej pozycjonować się w Google. GSC jest dobrze pomyślane i przejrzyste, a zarazem oferuje sporo możliwości, które trzeba zrozumieć. Temu ma służyć poniższy poradnik. Google Search Console krok po kroku, od podstaw do zaawansowanych funkcji!

Co to jest Google Search Console?

Google Search Console (często nazywane po prostu GSC) to narzędzie do analizowania wyników danej witryny w wyszukiwarce Google oraz diagnozowania problemów z tym związanych.

Narzędzie dostępne jest pod adresem: https://search.google.com/search-console

GSC jest podstawowym i niezbędnym narzędziem pracy specjalistów SEO, ponieważ prezentowane dane pochodzą prosto od Google.

Dawna nazwa narzędzia to Google Webmaster Tools. Zmiana nazwy miała miejsce w 2015 roku.

Korzystanie z GSC jest całkowicie darmowe, wymaga jedynie potwierdzenia naszych praw do danej witryny.

Jak dodać stronę do GSC?

W GSC możemy przeglądać dane dotyczące wielu witryn, których albo jesteśmy właścicielami, albo ich właściciele nadali nam odpowiednie uprawnienia. Pojedyncza witryna nazywana jest w GSC usługą.

Dodawanie nowej usługi (witryny) do GSC

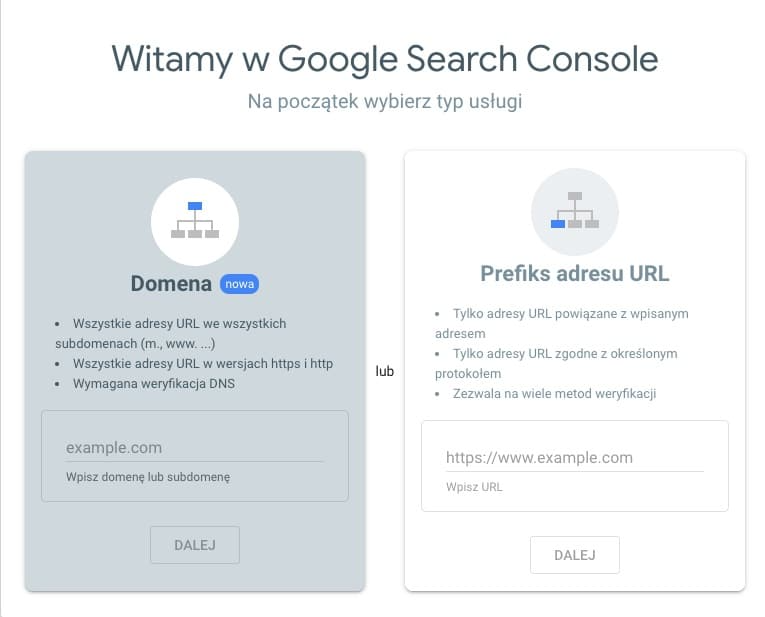

Przy dodawaniu nowej strony mamy do wyboru 2 typy usług:

1. Prefiks adresu URL to na przykład:

- htttp://senuto.com

- https://www.senuto.com

- http://senuto.com

- https://www.senuto.com

2. Cała domena (uwzględni wszystkie powyższe warianty)

Zdecydowanie lepszą metodą będzie ta druga, czyli dodanie całej domeny. Będziemy wtedy mieć pełny zakres informacji w jednym miejscu.

Po wybraniu odpowiedniej metody i uzupełnieniu danych pora na kolejny krok.

Weryfikacja własności domeny

Kolejnym etapem będzie weryfikacja własności domeny, potwierdzenie że faktycznie mamy uprawnienia do zarządzania nią.

Do wyboru mamy kilka metod weryfikacji własności domeny, w zależności od tego, jaki typ usługi wybraliśmy.

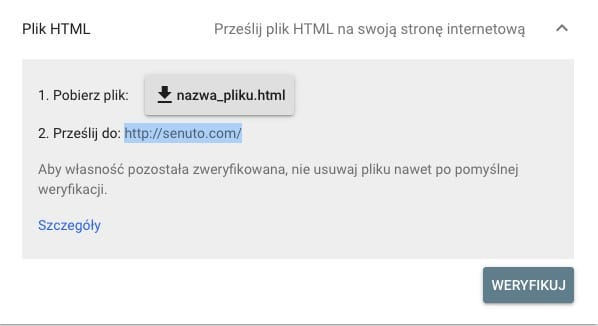

Przesłanie pliku weryfikacyjnego HTML na serwer

Pobieramy plik HTML z poziomu GSC i umieszczamy go na serwerze. Zwykle najszybszą metodą będzie skorzystanie z programu do FTP, np. FileZilla lub zlecenie dodania pliku administratorowi naszego serwera.

Ten sam plik wykorzystywany jest do weryfikacji różnych usług dla tego samego konta (maila).

Uwaga!

Plik weryfikacyjny musi pozostać na serwerze w niezmienionej formie. Usunięcie pliku będzie się wiązało z utratą dostępu do usługi.

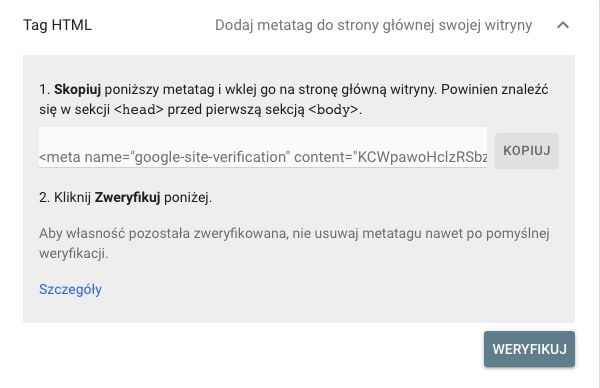

Dodanie metatagu weryfikacyjnego (Tag HTML)

Korzystanie z tej metody wymaga modyfikacji kodu HTML witryny przez dodanie do niego metatagu. W przypadku stron opartych na WordPress możemy zrobić to szybko, edytując plik header.php.

Weryfikacja przez Google Analytics

Jeśli na tym samym adresie mailowym, co GSC, mamy podłączone również Google Analytics, to możemy wykorzystać ten fakt do zweryfikowania własności.

Warunkiem koniecznym jest tu posiadanie uprawnień do edycji konta GA oraz kod śledzenia analytics.js lub gtag.js.

Weryfikacja przez Google Tag Manager

Analogicznie jak w przypadku GA, jeśli z tego samego konta mailowego korzystamy też do GTM zainstalowanego w danej witrynie, to możemy je wykorzystać do zweryfikowania naszych praw.

Konieczne będzie posiadanie uprawnień do publikacji na danym koncie GTM.

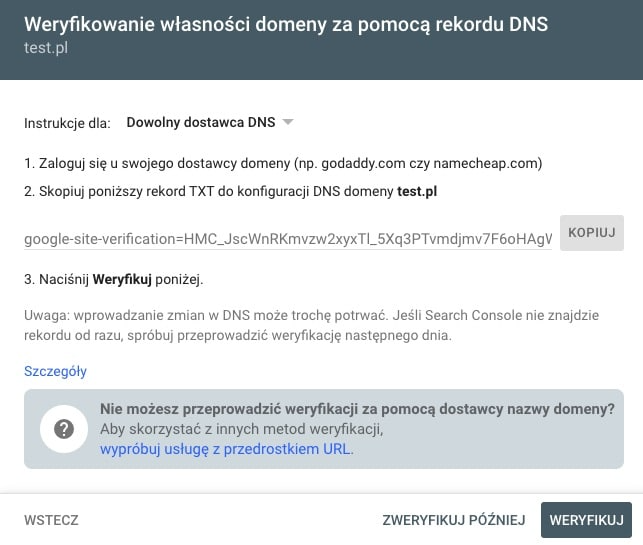

Dodanie rekordu w DNS domeny

Jest to jedyna dostępna metoda dla weryfikacji całej domeny (wszystkie warianty www i bez www, subdomeny).

Żeby skorzystać z tej metody, konieczny będzie dostęp do panelu dostawcy domeny.

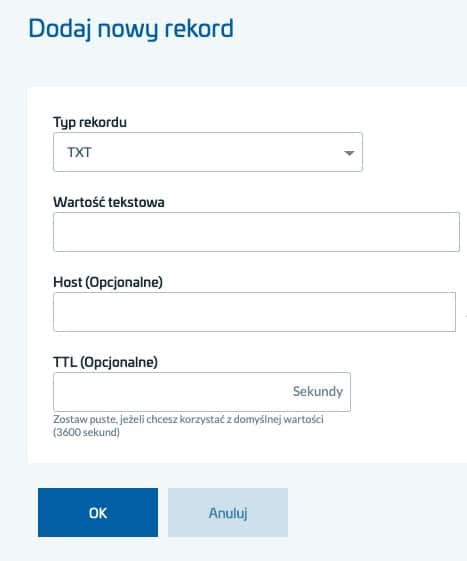

Na przykładzie AZ.pl po kolei należy:

- Zalogować się do panelu domen: https://cp.az.pl/

- Przejść do zakładki Domeny

- Przy interesującej nas domenie wybrać Zarządzaj rekordami DNS

- Kliknąć Dodaj nowy rekord

- Wybrać typ rekordu jako TXT

- Wkleić wartość podaną w GSC

Po wykonaniu którejś z metod weryfikacji klikamy Weryfikuj.

Czas weryfikacji

Jeśli konto GSC było tworzone po raz pierwszy, może minąć trochę czasu zanim pojawią się dane (do kilku dni).

Po tym czasie możemy już obserwować stan techniczny i wyniki swojej witryny.

Zarządzanie uprawnieniami użytkowników

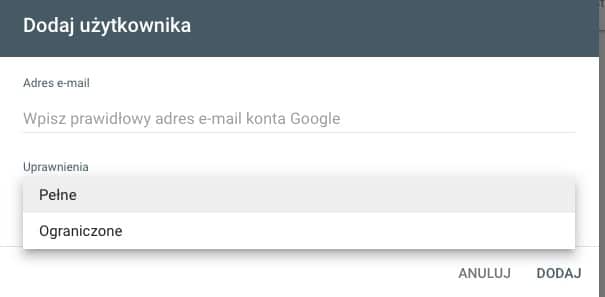

Właściciele witryn (czyli osoby, które dokonały weryfikacji własności) mają możliwość nadawania dostępu do danych kolejnym użytkownikom.

Można to zrobić w zakładce Ustawienia, w polu Użytkownicy i uprawnienia.

Do wyboru mamy 2 typy uprawnień:

- Pełne – osoby z takimi uprawnieniami mogą ingerować w ustawienia witryny i nadawać uprawnienia kolejnym użytkownikom

- Ograniczone – użytkownik z tym typem uprawnień jedynie może przeglądać raporty

Nawigacja po Google Search Console

GSC jest narzędziem bardzo przejrzystym (choć nie było tak zawsze). W zależności od typu witryny dostępne będą narzędzia i raporty:

- Przegląd

- Sprawdzanie adresu URL

- Skuteczność:

>Wyniki wyszukiwania

>Discover (tylko dla witryn wyświetlających się w Google Discover)

>Wiadomości Google (dla witryn, które się pojawiają w zakładce Wiadomości w wynikach wyszukiwania)

- Indeks:

>Stan

>Mapy witryn

>Usunięcia

- Ulepszenia:

>Podstawowe wskaźniki internetowe

>Obsługa na urządzeniach mobilnych

>AMP (dla witryn z wersją AMP)

>Menu nawigacyjne

>Logo

>Pole wyszukiwania w linkach domeny

>Pliki wideo

- Bezpieczeństwo i ręczne działania:

>Ręczne działania

>Problemy dotyczące bezpieczeństwa

- Starsze narzędzia i raporty:

>Kierowanie międzynarodowe

>Wiadomości

>Parametry w adresach URL

>Web Tools

- Linki

- Ustawienia

Dodatkowo istnieje narzędzie do zrzekania się linków przychodzących. Jest ono niedostępne z poziomu panelu, jednak jest częścią GSC.

Dostęp do narzędzia uzyskasz wchochodząc pod adres: https://www.google.com/webmasters/tools/disavow-links-main

Po kolei omówmy teraz wszystkie raporty i narzędzia, jakie oferuje Google Search Console.

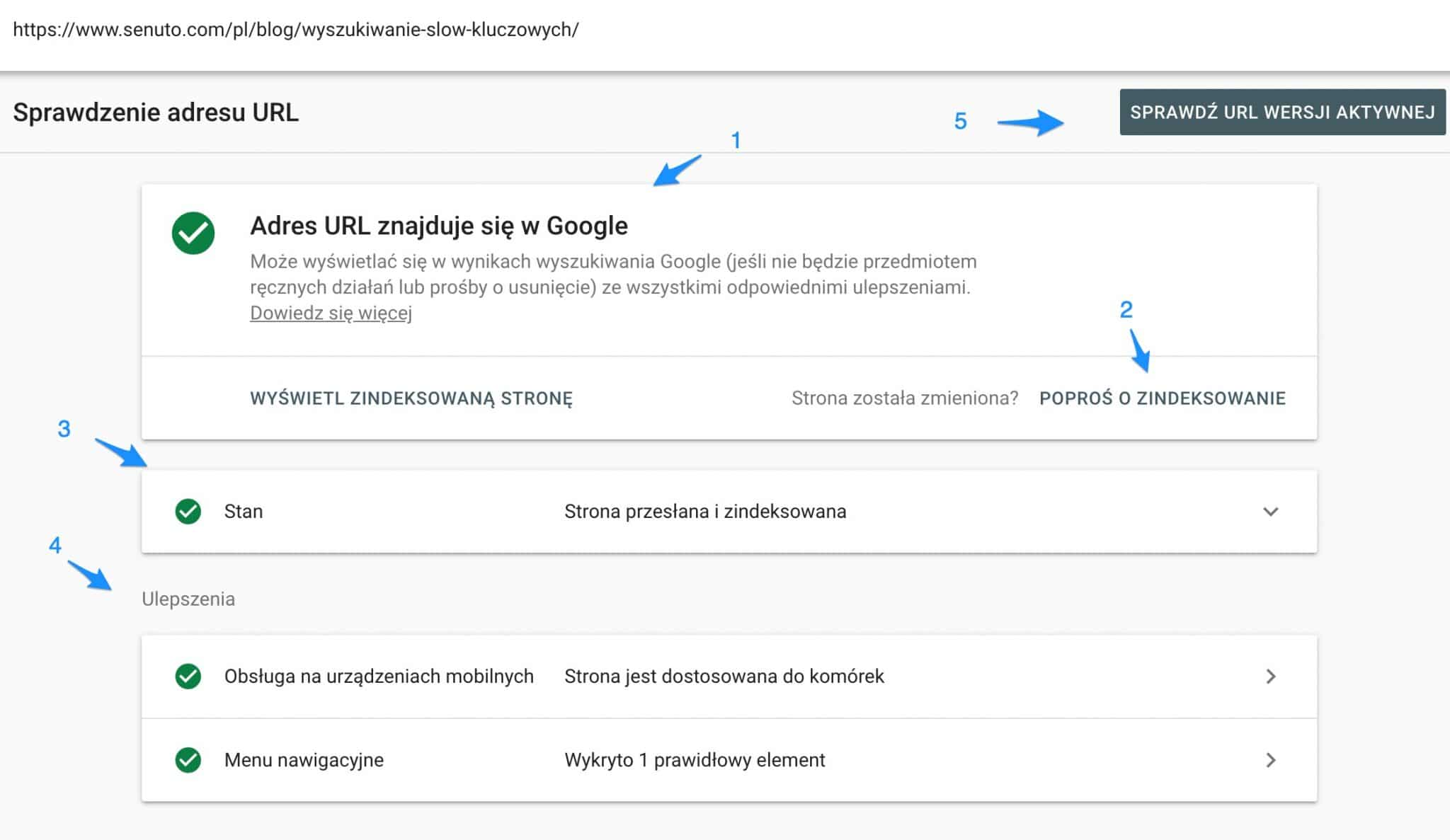

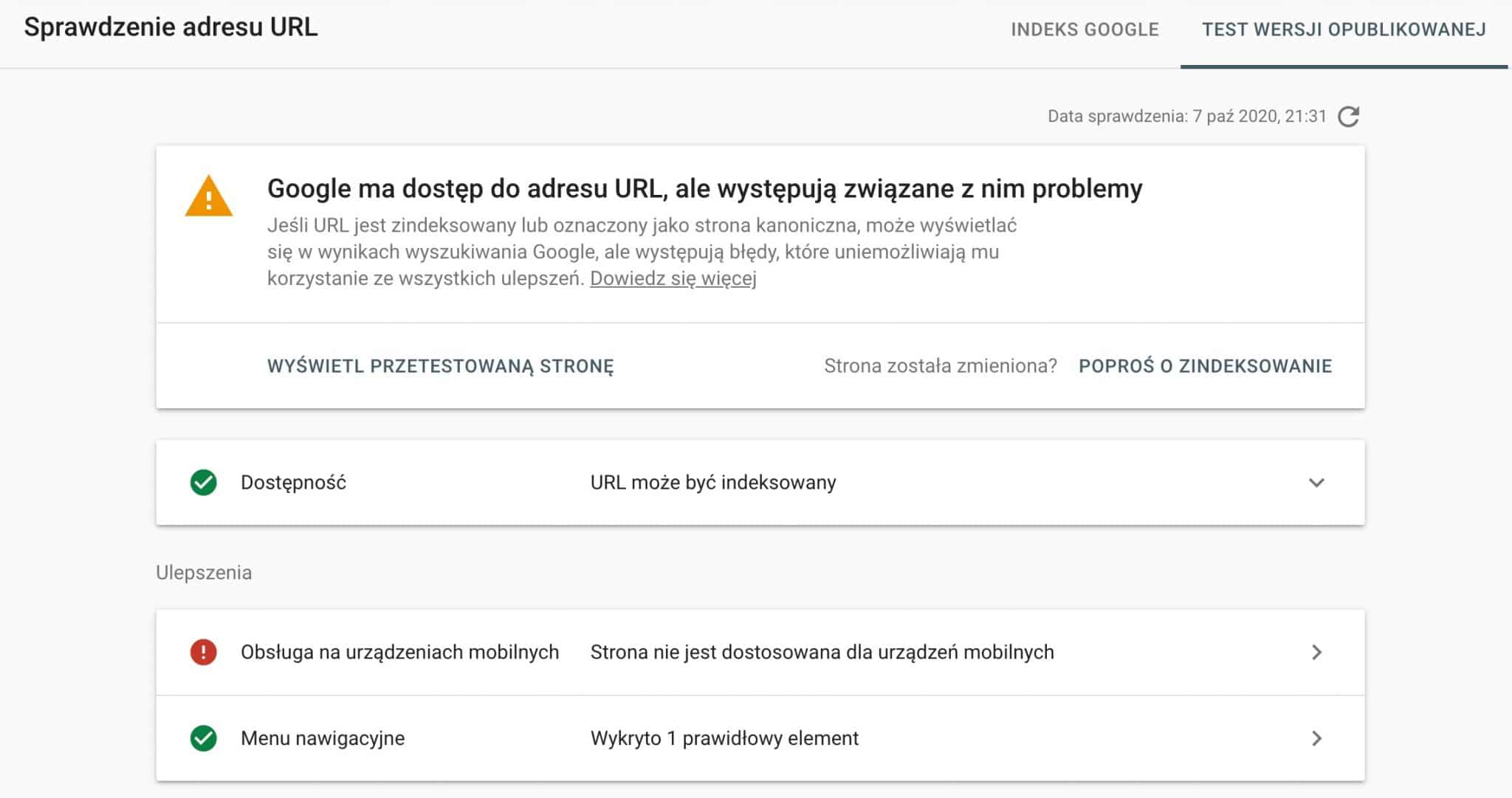

Sprawdzanie adresu URL

Funkcjonalność ta pozwala nam głównie diagnozować problemy związane z indeksacją konkretnych adresów URL.

Przykładowy raport dla jednego z artykułów na blogu Senuto:

Co ważne, wszystkie informacje pokazane w powyższym raporcie dotyczą danej podstrony, ale w wersji takiej, w jakiej zaindeksował ją Google.

1. Aktualny stan indeksacji, możliwe stany to:

-

- Adres URL znajduje się w Google – strona została poprawnie zaindeksowana

- Adres URL znajduje się w Google, ale występują związane z nim problemy – najczęściej są to błędy w implementacji danych strukturalnych lub błędy we wdrażaniu AMP

- Adres URL nie znajduje się w Google – roboty wyszukiwarki próbowały zaindeksować stronę, jednak natrafiły na problemy z tym związane

- Adres URL nie znajduje się w Google – adres URL nie jest zaindeksowany, najczęściej zgodnie z intencją właściciela strony

- Ten URL to wersja alternatywna – taką informację uzyskamy, gdy wpiszemy do sprawdzenia podstronę która jest np. wersją mobilną lub wersją AMP podstawowej podstrony

2. Jeśli nie jest zaindeksowany, możemy w tym miejscu zgłosić adres URL do zaindeksowania, albo jeśli dokonywaliśmy istotnych zmian – poprosić o zaindeksowanie z uwzględnieniem zmian. Uwaga! Aktualnie taka możliwość została wyłączona, w związku z trudnościami po stronie Google z indeksowaniem nowych treści.

3. Szczegóły związane ze Stanem indeksacji

4. Ulepszenia, czyli optymalizacja pod kątem urządzeń mobilnych i wykryte dane strukturalne

5. Sprawdzenie URL wersji aktywnej – tu sprawdzimy, czy Google jest w stanie indeksować aktualną wersję danego adresu URL (która może się różnić od tej już zaindeksowanej)

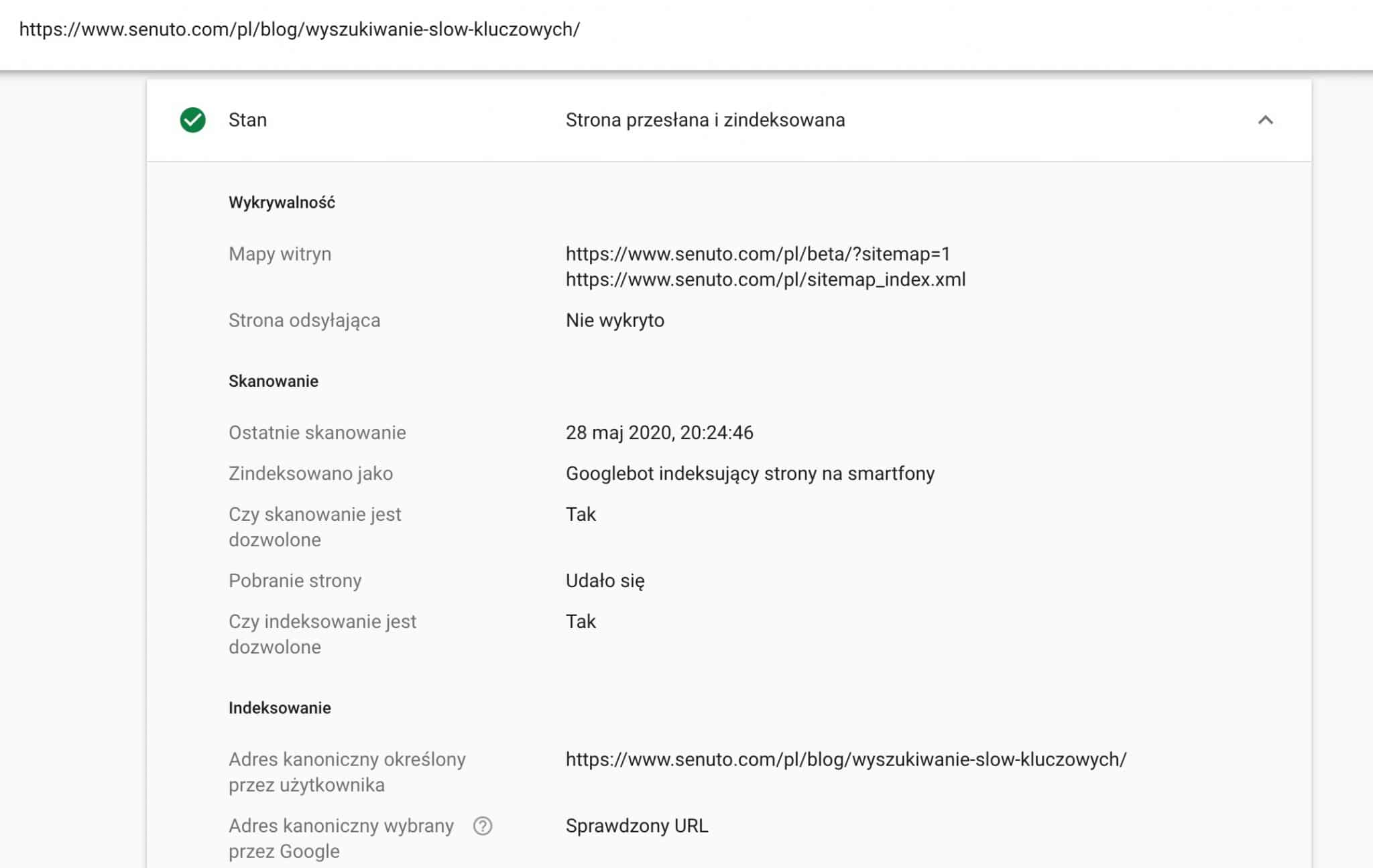

Stan

W tym miejscu poznamy więcej szczegółów związanych z indeksacją adresu URL.

Raport Stan podzielony jest na kilka sekcji: wykrywalność, skanowanie, indeksowanie. Odzwierciedla to sposób, w jaki działają roboty Google (trafiają na dany adres URL z różnych źródeł, skanują go, indeksują lub nie).

Wykrywalność

Informacje na temat tego, w jaki sposób robot Google trafił na dany adres URL. Najczęściej będzie to mapa witryny, rzadziej strona odsyłająca.

Skanowanie

Szczegóły związane z ostatnim skanowaniem (czyli odczytaniem przez roboty danej adresu URL):

- Ostatnie skanowanie – warto sprawdzić, czy strona jest odwiedzana tak często, jak byśmy tego chcieli

- Zindeksowane jako – typ robota Google, który skanował: desktopowy lub mobilny

- Czy skanowanie dozwolone – czy roboty nie widzą blokad przed skanowaniem (czyli odpowiednie dyrektywy w robots.txt lub meta robots)

Indeksowanie

W tej sekcji znajdziemy informacje dotyczące adresów kanonicznych (znaczników rel canonical):

- Adres kanoniczny określony przez użytkownika – jaki adres kanoniczny został wybrany przez nas

- Adres kanoniczny wybrany przez Google – jaki adres jest uznawany za kanoniczny przez Google.

Jest to najpewniejszy sposób, by sprawdzić, czy roboty wyszukiwarki respektują nasze znaczniki rel canonical, które są jedynie wskazaniem, a nie dyrektywą dla robotów.

Ulepszenia

W tej części raportu zebrane są informacje dotyczące optymalizacji pod kątem urządzeń mobilnych, a także dodatkowych tzw. “Ulepszeń” (oznaczeń w kodzie HTML dodatkowych elementów, które mogą się wyświetlać w wynikach wyszukiwania):

- Menu nawigacyjne (Breadcrumbs)

- Produkty (Dane związane z produktem: cena, dostępność)

- Fragmenty opinii (Recenzje i oceny produktów)

- Pole wyszukiwania w linkach do podstron

Sprawdź URL wersji aktywnej

Narzędzie to działa analogicznie, jednak pod uwagę brana jest aktualna wersja danej podstrony, a nie taka, jaką ostatnią zaindeksowały roboty Google.

Po odczytaniu danego URLa (może to chwilę potrwać) dostaniemy informację o zdolności do zaindeksowania danego adresu oraz poprawności wdrożenia ulepszeń.

Możliwe wyniki to:

- Google ma dostęp do adresu URL

- Google ma dostęp do adresu URL, ale występują związane z nim problemy – najczęściej związane z obsługą na mobile, danymi strukturalnymi, AMP

- Google nie ma dostępu do adresu URL – roboty mają zablokowany dostęp do adresu URL

- Ten URL to wersja alternatywna – podobnie jak w przypadku raportu sprawdzania adresu URL, wersja AMP lub mobilna

W sekcji Dostępność i Ulepszenia znajdziesz informacje analogiczne jak w przypadku standardowego sprawdzania adresu URL.

Wyświetl przetestowaną stronę

W tym miejscu mamy możliwość zobaczyć, w jaki sposób daną podstronę “widzą” roboty Google.

Zobaczyć to możemy w formie:

- Kodu HTML – jest to kod, który jest widoczny dla robotów po wyrenderowaniu podstawowego HTML oraz dodatkowych jego elementów za pomocą JS (na tyle, na ile się to udało Googlebotowi), w ten sposób sprawdzimy czy wszystkie istotne elementy są na pewno dobrze widoczne dla robotów

- Zrzut ekranu – odwzorowanie tego, w jaki sposób stronę zobaczyły roboty, najszybszy sposób sprawdzenia, czy wszystkie ważne elementy (treść, linki) poprawnie się wczytują

- Więcej informacji – status HTTP, ewentualne błędy związane z ładowaniem treści przez JavaScript (będą przydatne do diagnozowania problemów z ładowaniem treści przez JS), załadowane zasoby

To narzędzie będzie szczególnie przydatne do sprawdzania problemów z witrynami w dużej części opartych o JS.

Do czego przyda się narzędzie sprawdzania adresu URL?

Narzędzie sprawdzania adresu URL jest przede wszystkim bardzo pomocne w pracy nad technicznymi aspektami witryny i w diagnozowaniu problemów z indeksacją.

Bardzo cenna jest także możliwość samodzielnego zgłoszenia nowego/zaktualizowanego adresu URL do zaindeksowania.

Zastosowania:

- Zgłaszanie nowych treści do zaindeksowania

- Zgłaszanie zaktualizowanych treści do zaindeksowania

- Sprawdzenie, czy strona jest odczytywana poprawnie: czy widoczna jest cała istotna treść

- Sprawdzenie, czy roboty Google respektują przyjęte przez nas znaczniki canonical

- Diagnozowanie problemów z JS SEO (więcej na ten temat: https://www.onely.com/blog/ultimate-guide-javascript-seo/)

Skuteczność

Poprzednie narzędzia i raporty były stricte techniczne, z kolei raporty z zakładki Skuteczność są czysto analityczne.

Większość właścicieli witryn zobaczy tu raport dotyczący wyników organicznych, natomiast jeśli treści z Twojej strony wyświetlają się też w Google Discover, zobaczysz jeszcze jeden dodatkowy raport Discover.

Jak rozumieć dane z GSC?

Zanim przejdziemy do omawiania raportów warto napisać parę słów o sposobie zbierania danych i o tym, jak należy je interpretować.

Metryki

Istnieje kilka metryk (inaczej liczb), które zobaczymy w GSC. Poniżej dokładny opis, w jaki sposób je rozumieć.

Kliknięcia

Podstawowa metryka, która reprezentuje liczbę kliknięć – przejść z wyników wyszukiwania do danej strony.

Zasady zliczania kliknięć:

- Kliknięcie w wynik wyszukiwania, ponowne przejście do wyników wyszukiwania i kliknięcie w dany wynik jeszcze raz zostanie zaliczone jako 1 kliknięcie

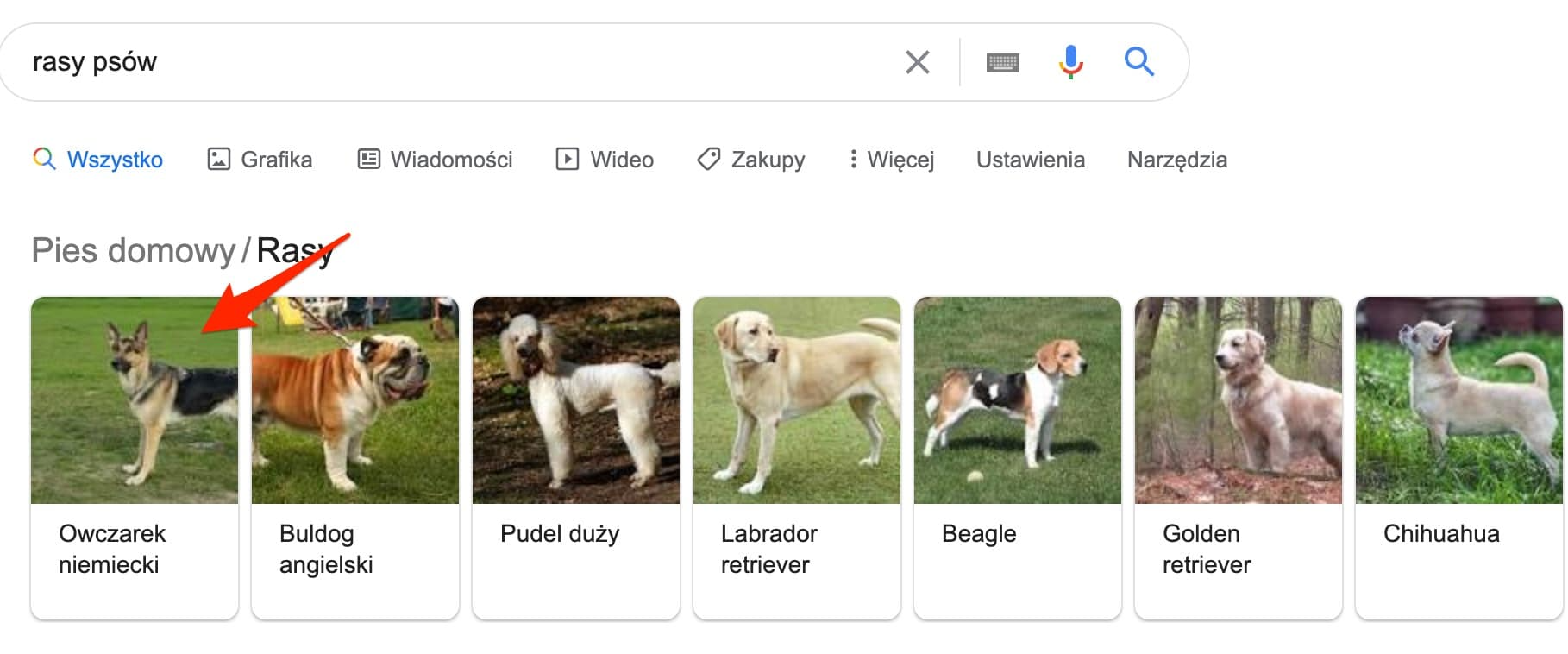

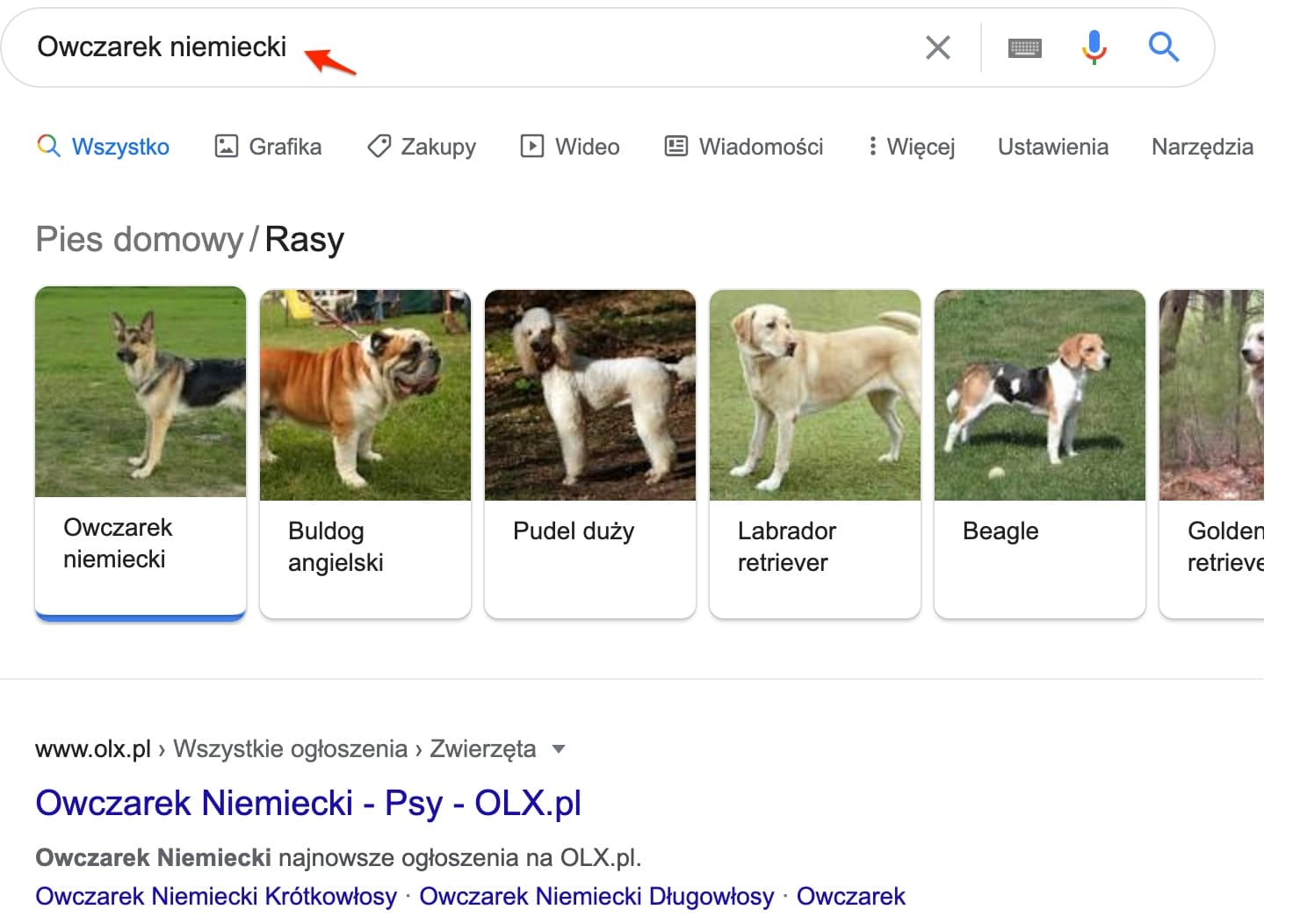

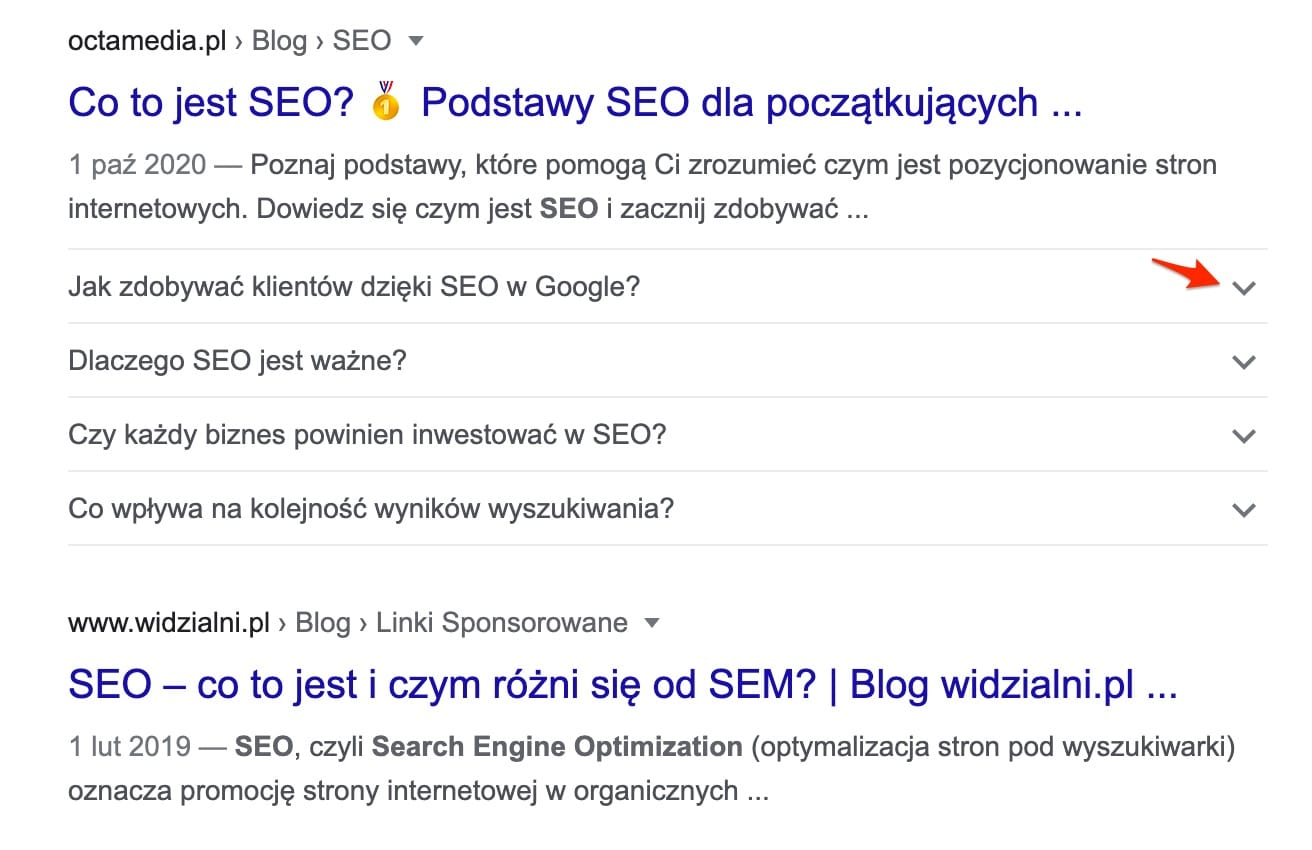

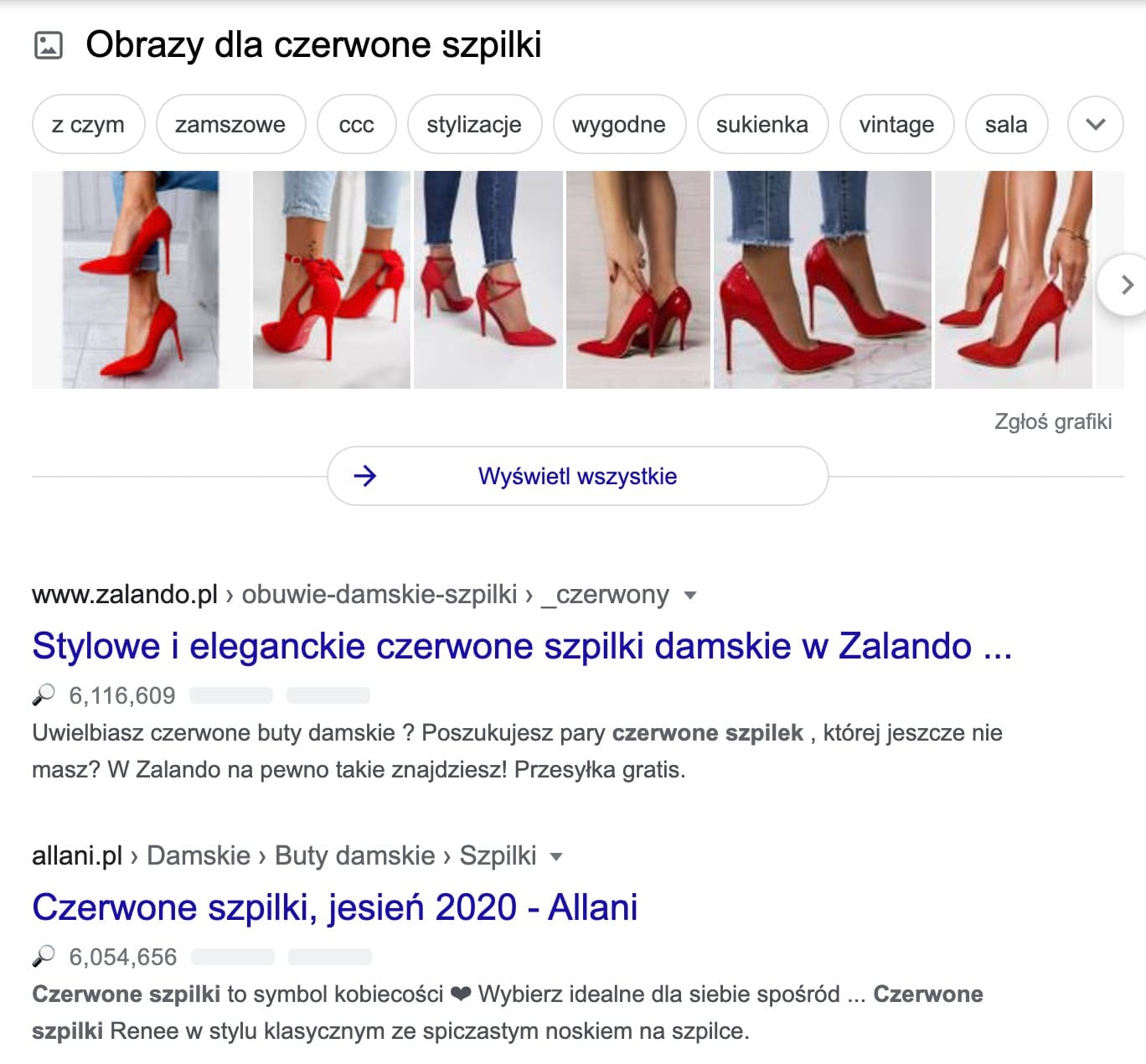

- Kliknięcie w element graficzny, który przenosi do wyników wyszukiwania dla innej frazy nie jest zliczane (przykład 1 poniżej)

- Kliknięcie w elementy takie jak najczęściej zadawane pytania (FAQ), które nie przenosi na stronę, a pokazuje dodatkowe informacje, również nie jest zliczane (przykład 2 poniżej)

Przykład 1:

Przykład 2:

Wyświetlenia

Są zliczane za każdym razem, kiedy link do Twojej strony został wyświetlony na stronie wyników wyszukiwania.

Warto zaznaczyć, że ten sam link może pojawić się na stronie kilka razy.

Wyświetlenie jest liczone nawet, jeśli zobaczenie wyniku wymagało przescrollowania strony z wynikami, np. jeśli nasza strona jest na 9. pozycji, a na pierwszym ekranie zobaczyliśmy 5 wyników.

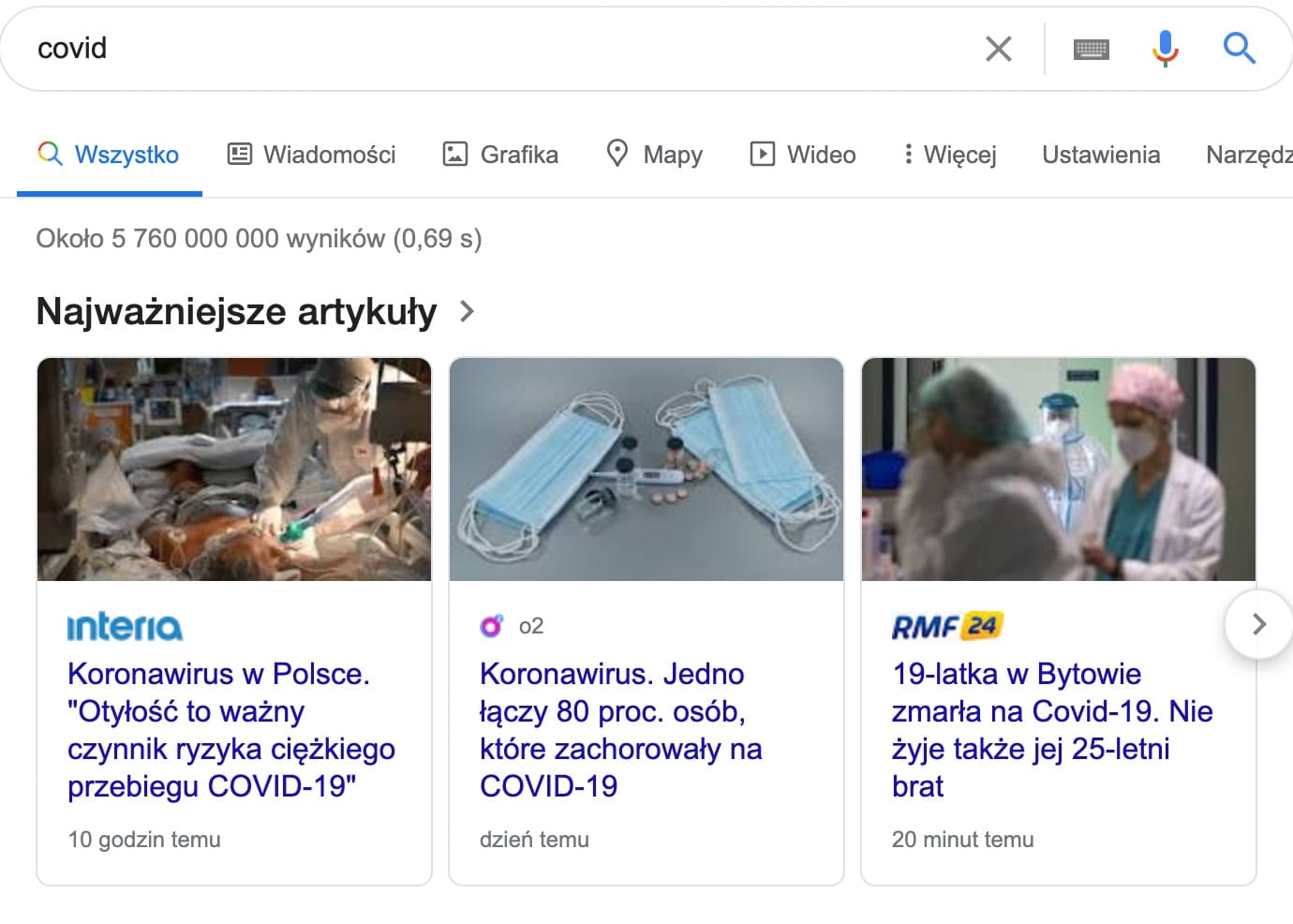

Nieco inaczej wygląda to w przypadku tzw. karuzeli (stosowanej do wyników z newsami oraz grafik).

Jeśli wynik z naszej strony nie jest od razu widoczny (wymaga przewinięcia karuzeli), nie jest zaliczone wyświetlenie. Będzie zaliczone dopiero po przesunięciu karuzeli.

Na poniższym ekranie wyświetlenia zostaną zaliczone pierwszym trzem stronom, mimo że w karuzeli jest więcej wyników.

Jeśli na stronie wyników wyświetlanych jest kilka różnych podstron z naszego serwisu, każda z nich otrzyma po 1 wyświetleniu.

Jeśli jednak ten sam adres URL wystąpi kilka razy, zostanie zarejestrowane tylko 1 wyświetlenie.

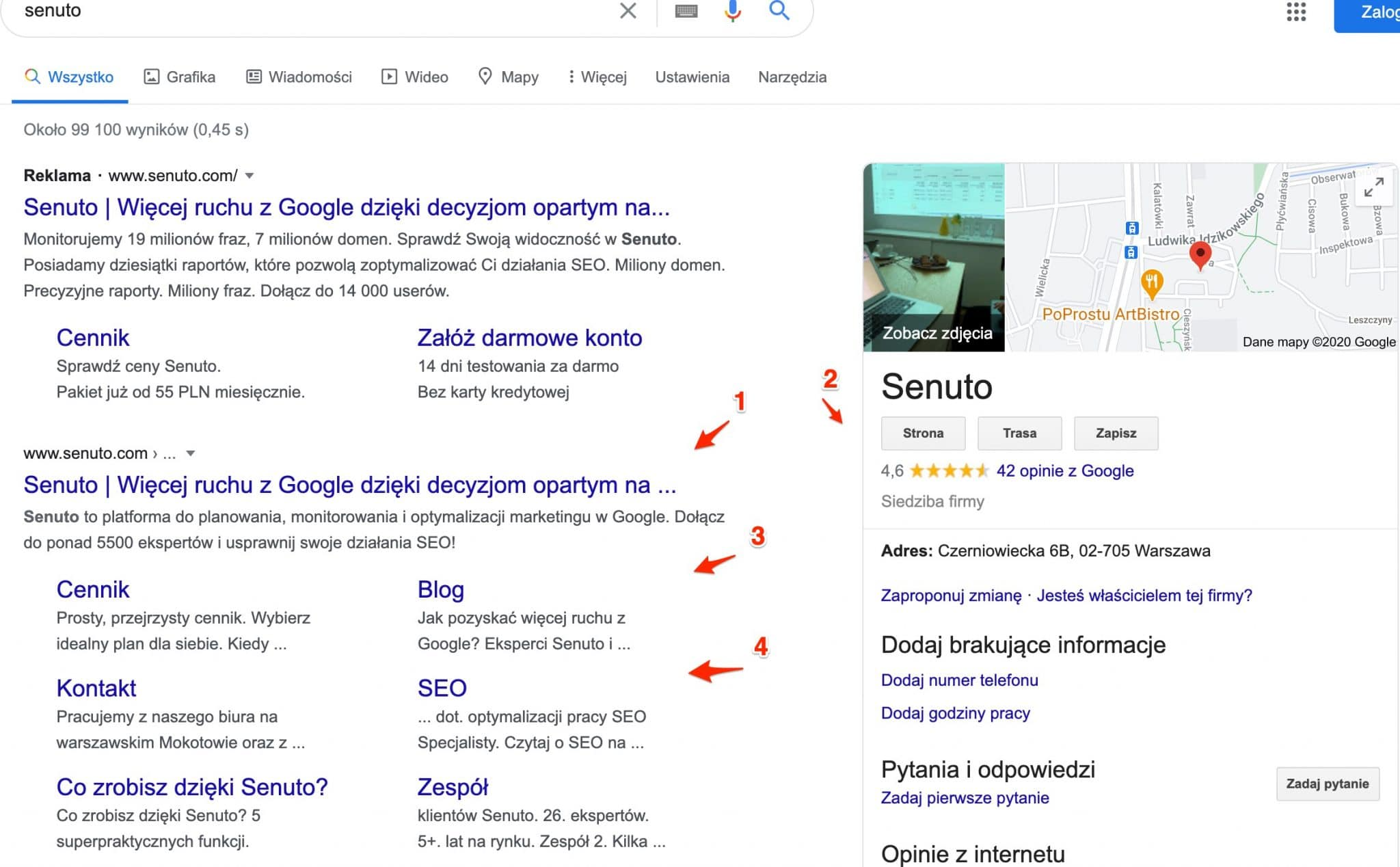

Przykład takiej sytuacji:

Mamy tu:

1 – https://www.senuto.com/pl/ – 1 wyświetlenie

2 – https://www.senuto.com/pl/

3 – https://www.senuto.com/pl/blog/ – 1 wyświetlenie

4 – https://www.senuto.com/pl/seo/ – 1 wyświetlenie

Jednakże jednocześnie dla całej domeny wyświetlenie zostanie zaliczone tylko pojedynczo.

Jak to możliwe?

W GSC dane możemy przeglądać:

- pogrupowane wg usługi (domeny), czyli dane zagregowane, nie pogrupowane np. z podziałem na strony czy kraje. Takie liczby zobaczysz np. na głównym wykresie w raporcie skuteczność

- pogrupowane wg adresów URL

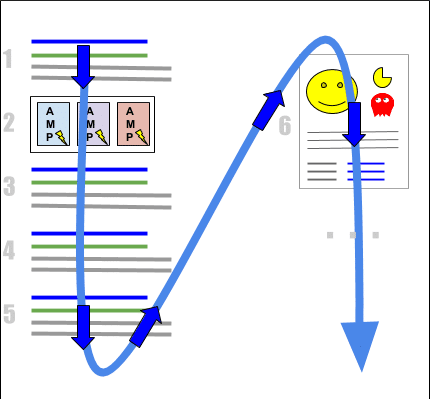

Pozycja

Pozycja Twojej strony jest przypisana na podstawie pozycji linka w wynikach wyszukiwania, który do niej prowadzi.

Wyniki są liczone od góry do dołu oraz od lewej po prawej, w sposób przedstawiony na infografice:

W jaki sposób wyliczana jest średnia pozycja?

- W raportach GSC widoczna jest zawsze średnia pozycja, zliczona na podstawie wszystkich wyświetleń, tzn. jeśli podczas kolejnych wyświetleń w wynikach dana podstrona była odpowiednio na 2., 3. i 5. pozycji, to jako średnia pozycja zostanie odnotowane 3,33

- W przypadku kilku wyników z tej samej domeny, liczony jest tylko ten najwyżej.

CTR

Na podstawie średniej pozycji i liczby kliknięć określany jest współczynnik CTR, czyli Click Through Rate. Mówi on nam o tym, jaki procent użytkowników spośród tych, którzy wyświetlili dany wynik, kliknęli w niego.

Wymiary

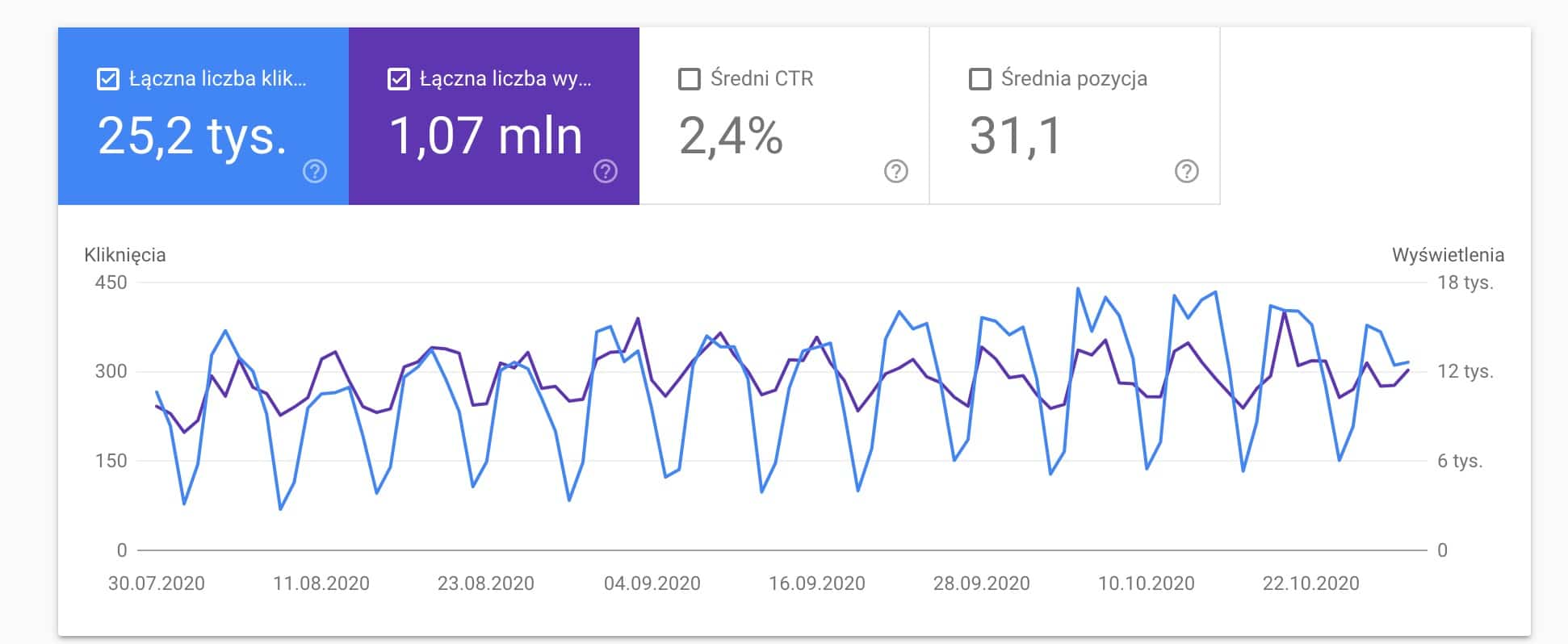

Poznaliśmy już najważniejsze metryki, które możemy zobaczyć w GSC. Sama informacja o liczbie kliknięć i wyświetleń dla witryny zwykle nie powie nam wiele, jeśli nie zagłębimy się w dane. Do tego właśnie posłużą nam wymiary, które dzielą dane i pomagają lepiej je analizować. Poniżej opis wszystkich występujących w raportach Google Search Console.

Zapytanie

Najważniejszym wymiarem, z którego pewnie będziesz korzystać najczęściej, są zapytania. Domyślnie informacje o kliknięciach, wyświetleniach, pozycji i CTR są podzielone właśnie według zapytań.

Zapytanie to nic innego jak słowo kluczowe, które zostało wpisane w wyszukiwarkę, nim w wynikach wyszukiwania pojawiła się Twoja strona.

Co ważne, część z danych o zapytaniach nie jest widoczna w raportach GSC. Dotyczy to bardzo rzadkich zapytań, które zostały użyte na tyle rzadko, że mogłyby pomóc zidentyfikować użytkownika, który dane zapytanie wpisał.

Strona

Adres URL, pod który trafił użytkownik po wejściu na stronę z wyników wyszukiwania.

Istotne zasady:

- Jeśli dany adres URL jest oznaczony w kodzie HTML jako duplikat innego adresu URL (kanonicznego), to kliknięcia i wyświetlenia są w większości przypadków przypisane do tej kanonicznej strony.

- Powyższa zasada nie ma zastosowania do wersji mobilnych na osobnej subdomenie, tzn. jeśli wyświetlony w wynikach adres URL to m.domena.pl i ma on canonical do wersji destkopowej, to i tak zliczony jest adres m.domena.pl

- W przypadku adresów URL z przekierowaniami, istotny jest adres URL, który pojawił się w wynikach wyszukiwania, nawet jeśli użytkownik w wyniku przekierowania docelowo zobaczy inny adres URL.

Kraj

Kraj, z którego było wykonywane wyszukiwanie.

Urządzenie

W zależności od urządzenia, Twoja witryna może być wyświetlona w wersji: na komputery, urządzenia mobilne lub tablety.

Uwaga!

Pamiętaj, że jeśli wersja mobilna Twojej witryny jest na osobnej subdomenie (np. m.domena.pl), to nie zobaczysz tu danych o urządzeniach mobilnych, o ile nie masz danych dla całej domeny (weryfikacja przy użyciu DNS).

Wygląd w wyszukiwarce

W zależności od tego w jaki sposób dane zostały przedstawione, możemy tu zobaczyć podział na:

- Wyniki AMP bez elementów rozszerzonych – klasyczne wyniki wyszukiwania, gdzie jako link do Twojej strony jest jej wersja AMP

- Artykuł AMP – głównie wyniki z karuzeli newsów “Najważniejsze wiadomości” lub jakiekolwiek inne wyniki, gdzie poza samym linkiem do wersji AMP jest dodatkowa grafika lub fragment treści

- Wyniki dla elementów rozszerzonych – jakiekolwiek wyniki wyszukiwania wzbogacone o dodatkowe elementy (spośród dostępnych w tzw. galerii rozwiązań: https://developers.google.com/search/docs/guides/search-gallery)

- Pliki wideo – wyniki zawierające wideo

- Wyniki web light – wyniki z lżejszymi wersjami witryn, przeznaczone dla wolniejszych łączy internetowych

- Fragmenty opinii – wyniki zawierające informacje o opiniach (np. recenzja filmu lub strona produktu w sklepie)

- Wyniki związane z produktem – SERPy z informacjami o produkcie, np. cena i dostępność

- Aplikacja na Androida – wyniki w których pojawił się link do zainstalowania aplikacji Androidowej (zwykle to frazy brandowe lub będące nazwą aplikacji)

Na jednej stronie wynikowej możemy mieć kilka stron, które będą przypisany do kilku powyższych kategorii, np. jedna strona AMP i jedna zawierające elementy rozszerzone.

Wyniki “bez fajerwerków” (żadnych dodatkowych elementów) nie mają osobnej wydzielonej kategorii.

Daty

Po prostu dane podzielone wg dni.

Raport Wyniki wyszukiwania

Wiemy już jak interpretować dane, które zobaczyliśmy. Pora teraz zapoznać się z możliwościami, jakie daje nam raport “Wyniki wyszukiwania”, który dotyczy skuteczności witryny w wyszukiwarce Google.

Nawigowanie po raporcie

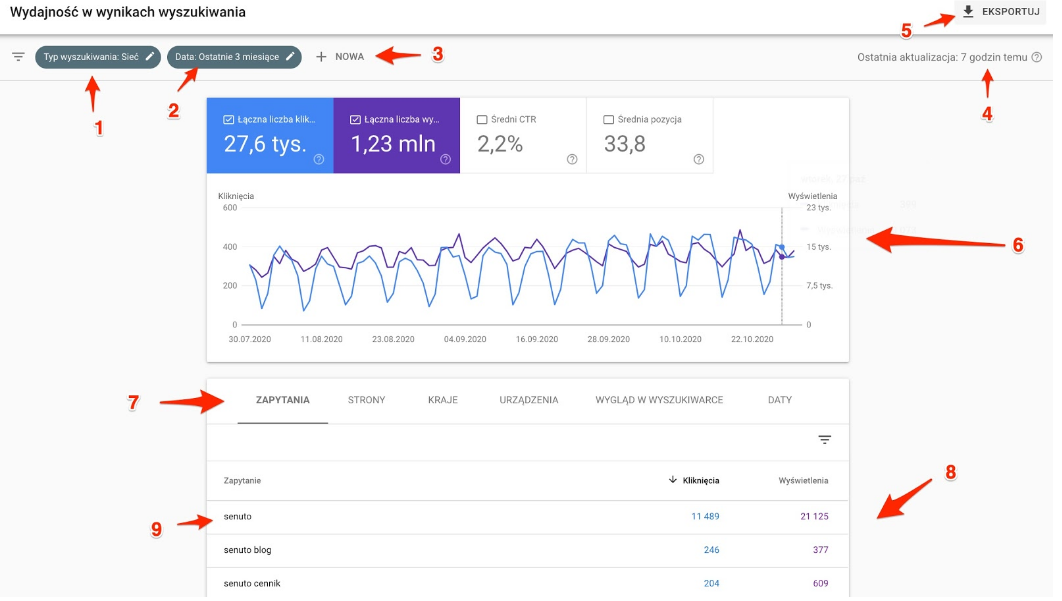

Najważniejsze elementy raportu wyników wyszukiwania przedstawiłem na poniższej grafice:

Kolejne elementy to:

- Typ wyszukiwania

- Zakres dat i porównanie danych

- Filtry

- Data aktualizacji danych

- Eksport danych

- Podsumowanie danych i wykres

- Wymiary danych

- Pełny raport

- Głębsza analiza

Szczegółowo opisałem je niżej.

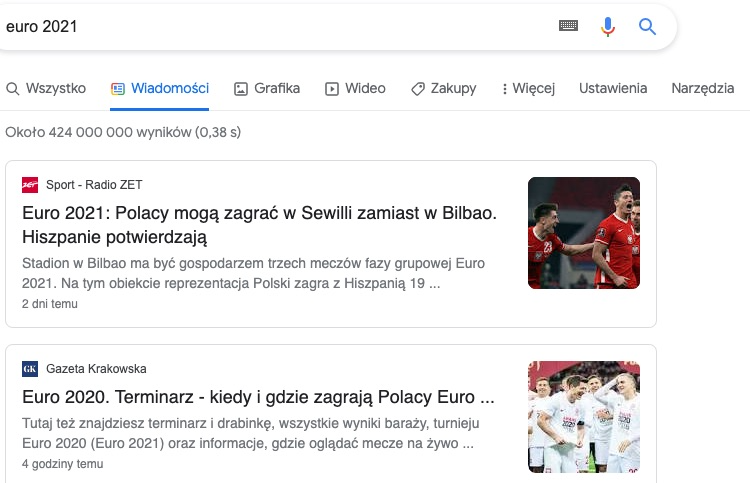

Typ wyszukiwania

Do wyboru mamy tu kilka opcji:

- Sieć

- Grafika

- Wideo

- Wiadomości

Każda z opcji jest odpowiednikiem określonej zakładki z wyników wyszukiwania. Wyniki widoczne w zakładce Wszystko są odpowiednikiem typu wyszukiwania Sieć w GSC.

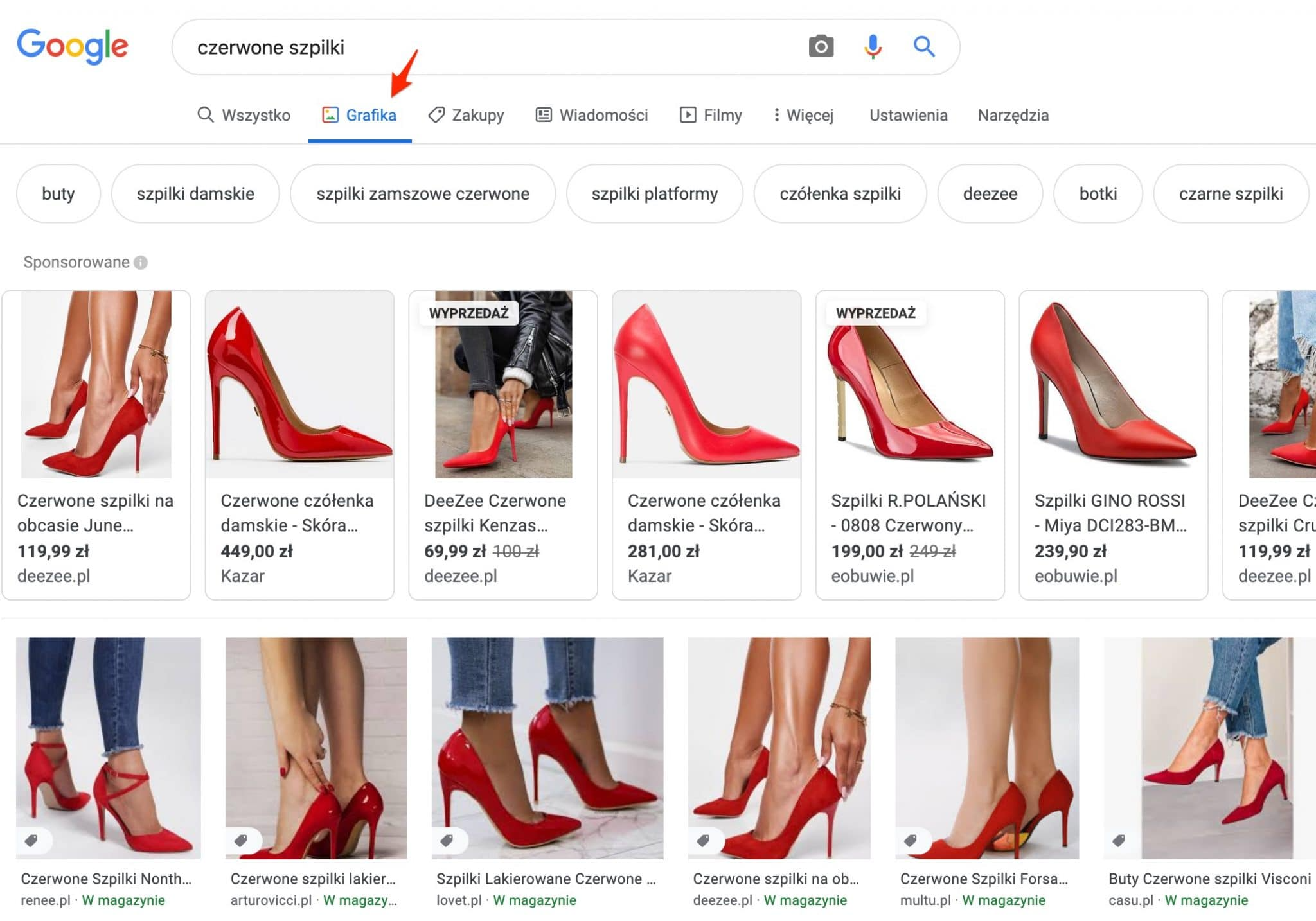

Nazewnictwo może być tu mylące, zawężenie typu wyszukiwania Grafika nie oznacza wyników graficznych, które często są widoczne nad klasycznymi wynikami, tak jak np. tutaj:

Wybierając “Grafika” będziemy widzieli dane dotyczące tylko i wyłącznie wyników z zakładki Grafika w Google.

Zakres dat i porównanie danych

Domyślny przedstawiony zakres czasu to 3 miesiące.

Do wyboru mamy jeszcze:

- Najnowsza data, z której zebrano dane (zwykle wczoraj)

- Ostatnie 7 dni

- Ostatnie 28 dni

- Ostatnie 6 miesięcy

- Ostatnie 12 miesięcy

- Ostatnie 16 miesięcy (maksymalny zakres)

Poza zmianą zakresu danych, możemy też porównać dane dotyczące 2 zakresów czasu (do wyboru analogicznie jak w przypadku zakresu dat, np. 3 mc vs poprzednie 3 mc lub dowolnie wybrane daty).

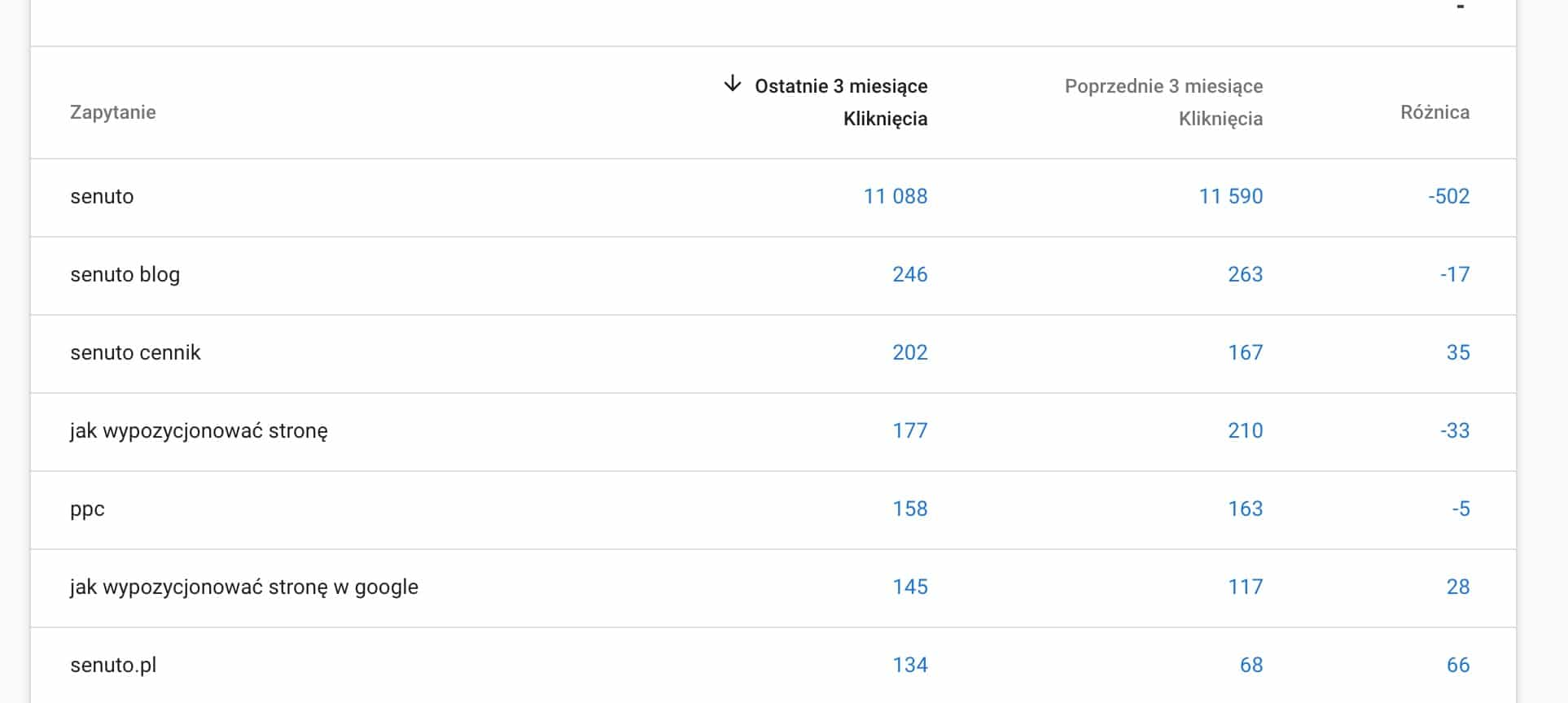

Po zastosowaniu porównania zobaczymy w raporcie różnicę w kliknięciach między wybranymi okresami danych.

Filtrowanie danych

Kolejną przydatną opcją jest możliwość filtrowania (zawężania) danych.

Filtr możemy zastosować do każdego z dostępnych wymiarów, czyli:

- Zapytań (zapytania zawierające jakiś ciąg znaków, niezawierające jakiegoś ciągu lub dokładne zapytanie)

- Stron (adresy URL zawierające/niezawierające jakiś ciąg, np. “blog” lub dokładny adres URL)

- Kraj (lista do wyboru spośród tych, z których witryna odnotowała wejścia)

- Urządzenie (lista do wyboru)

- Wygląd w wynikach wyszukiwania

Eksportowanie danych

Do wyboru mamy 3 opcje/formaty:

- Dokument Google Spreadsheets

- Plik MS Excel

- Plik CSV

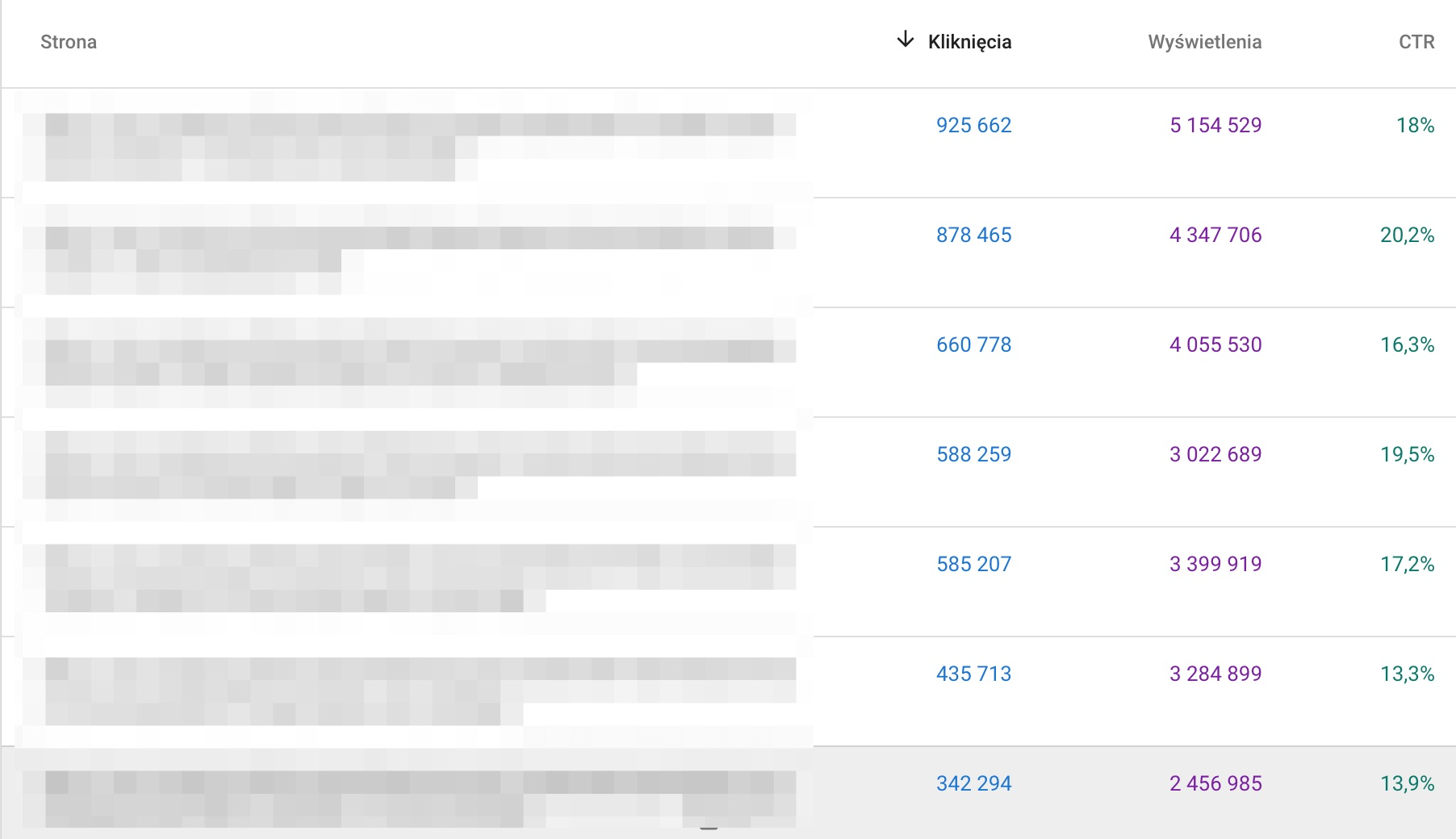

Niezależnie od formatu, eksportując dane dostaniemy kilka raportów, zawierających dane w podziale na wszystkie możliwe wymiary (Strony, Zapytania itp.)

Co istotne, zarówno przeglądając dane w GSC, jak i w eksporcie, dostaniemy tylko ograniczoną część danych. Zwykle jest to 1000 wierszy w każdym z raportów.

W przypadku mniejszych witryn często dostaniemy więc pełne dane. Natomiast eksportując dane dużego serwisu, notującego kilka milionów kliknięć miesięcznie, zobaczymy tylko część danych (np. 20-30%). Na szczęście są sposoby na uzyskanie pełnych danych – o tym będzie za chwilę.

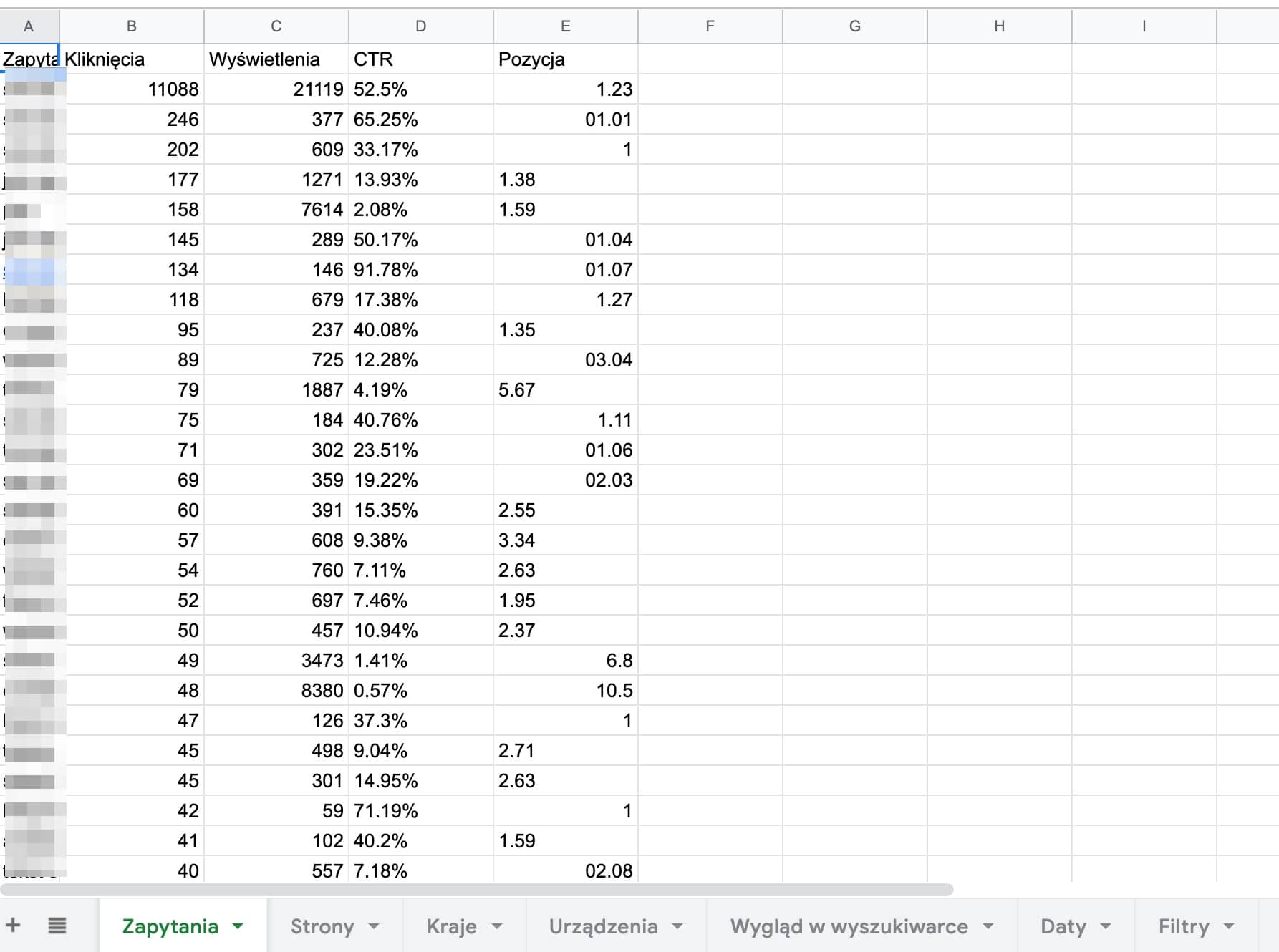

Podsumowanie danych i wykres

W podsumowaniu danych zobaczymy najważniejsze statystyki, czyli liczbę kliknięć, wyświetleń oraz średnie pozycje i CTR.

Dane te przedstawione są zbiorczo, dla całej witryny.

Na wykresie możemy zobaczyć wszystkie z 4, wystarczy kliknąć w odpowiedni kafelek.

Wymiary danych

Pod wykresem mamy dostępne zakładki z wymiarami danych i raporty danych. Tymi, z których zapewne będziesz korzystał najczęściej są Zapytania i Strony.

Przełączenie się między zakładkami zmienia dane wyświetlane w pełnym raporcie poniżej.

Pełny raport

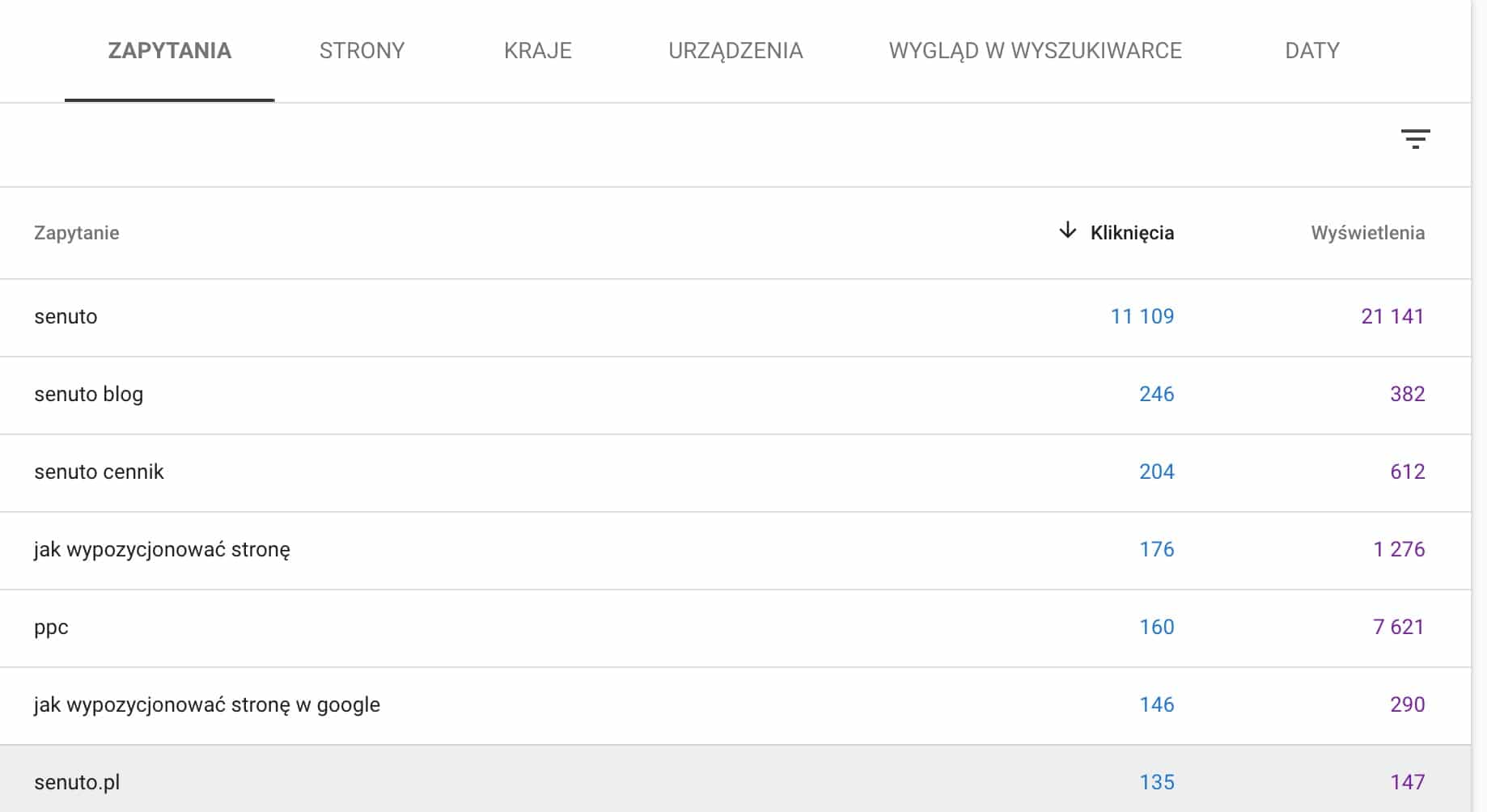

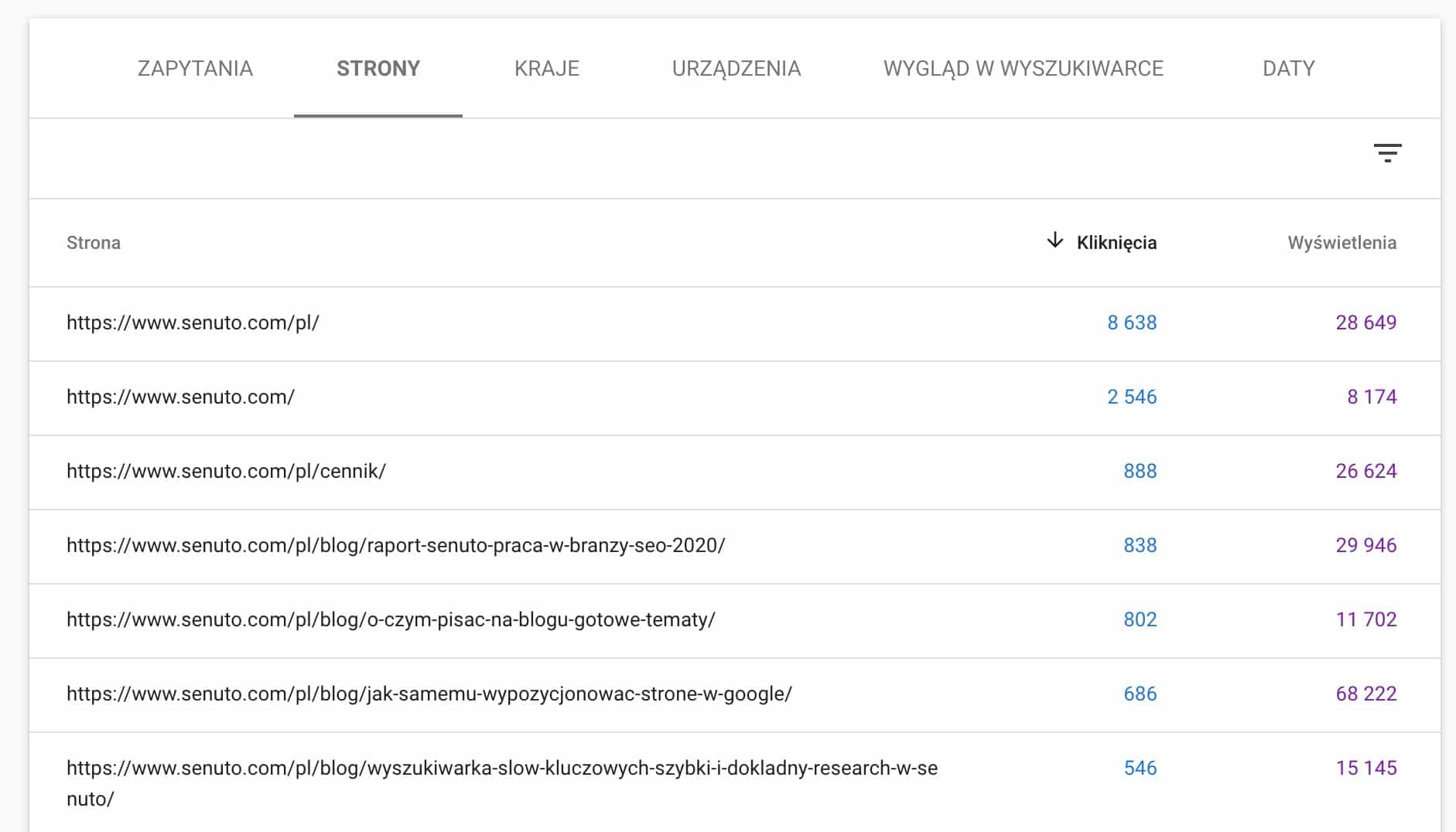

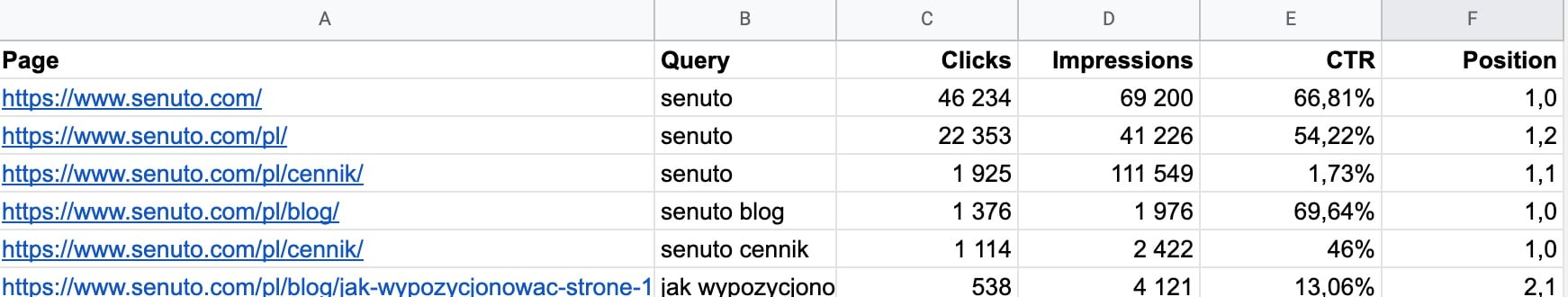

Przechodzimy teraz do najważniejszej części, czyli raportu danych. Zwykle najczęściej analizować będziemy raport zapytań i raport stron.

Raport dla zapytań przedstawia liczbę kliknięć, wyświetleń dla każdej z fraz. Jeśli chcemy zobaczyć także informację o średniej pozycji i CTR wystarczy kliknąć w odpowiedni kafelek nad wykresem.

Analogicznie, w raporcie stron zobaczymy, jak kliknięcia i wyświetlenia rozkładają się ze względu na strony.

Z tego miejsca raportu możemy też przejść do analizy danego adresu URL w raporcie “Sprawdzanie adresu URL”. Wystarczy najechać na dany adres, a pojawi się przy nim lupka umożliwiająca przejście do tego raportu.

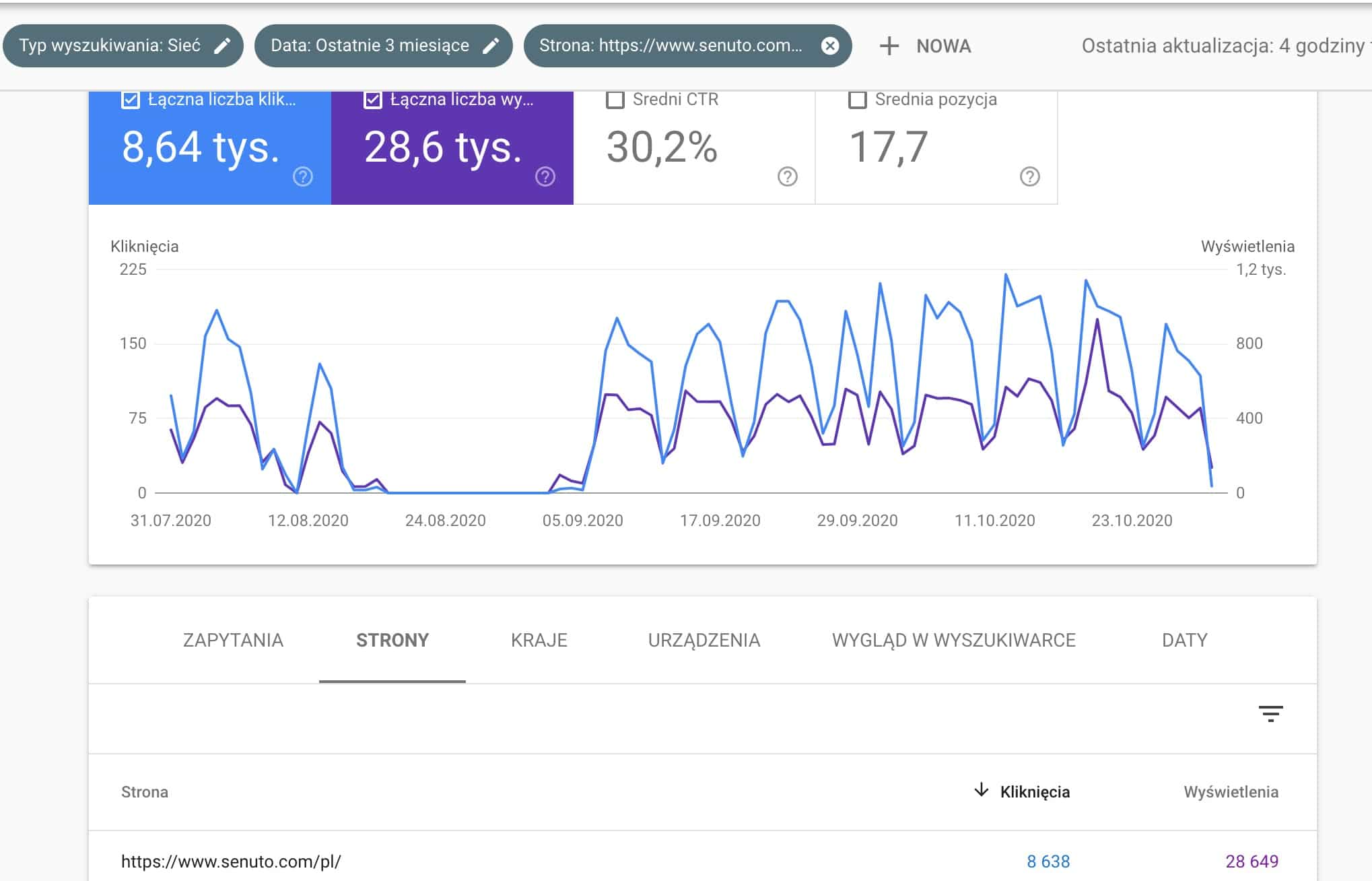

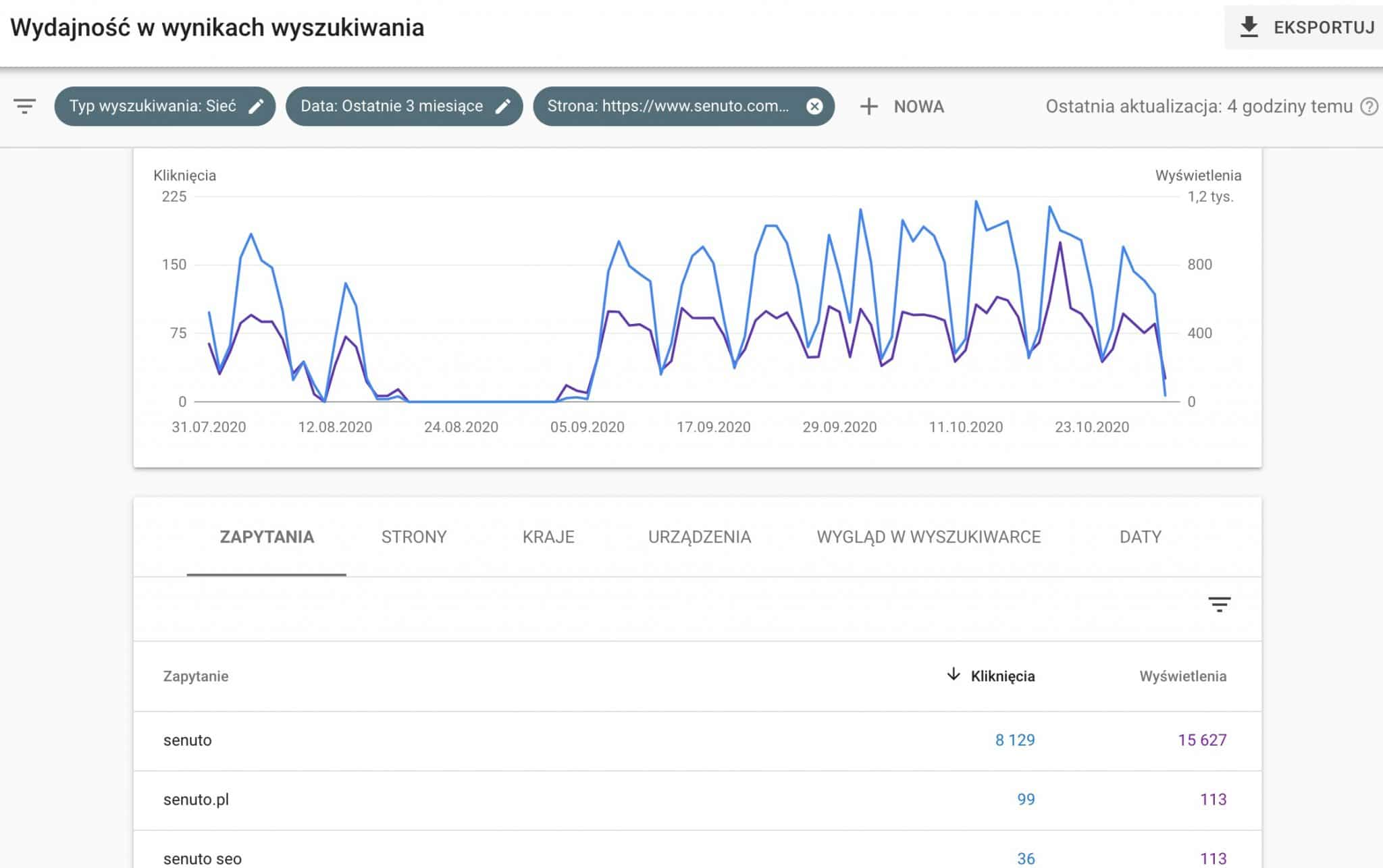

Głębsza analiza

Klikając w którąś z wartości w raporcie (np. konkretne zapytanie lub stronę) zawężamy raport. Przykładowo, będąc w raporcie stron, jeśli klikniemy konkretny adres URL, wszystkie dane w raporcie będą dotyczyć tylko wejść na tę jedną stronę.

Również po przełączeniu na inne zakładki.

Efekt wybrania danych w naszym GSC, które dotyczą tylko strony głównej:

Po przełączeniu na zakładkę Zapytania:

Zauważ, że w polu filtrów pojawił się filtr dotyczący tej strony. Taki sam efekt zawężenia danych można by więc uzyskać przez filtry.

Wykorzystanie API Google Search Console do uzyskania pełnych danych

Jak wcześniej wspominałem, pewnym ograniczeniem jest dostęp tylko do części z danych (1000 wierszy), które mogą nie dawać pełnego obrazu. Na szczęście Google udostępnia API, dzięki któremu możemy:

- Wykorzystać dane z GSC w zewnętrznych narzędziach, jak np. Senuto, Screaming Frog czy Google Docs i zestawić je z innymi danymi (np. o widoczności w przypadku Senuto czy z informacjami o linkowaniu wewnętrznym w Screaming Frog)

- Uzyskać pełne dane (bez żadnego limitu), które pozwolą na pełniejszą analizę

- Zautomatyzować pobieranie danych z GSC dla wielu witryn internetowych

Integracja GSC w Senuto

O tym, jak taką integrację wykonać dowiesz się z wiki Senuto.

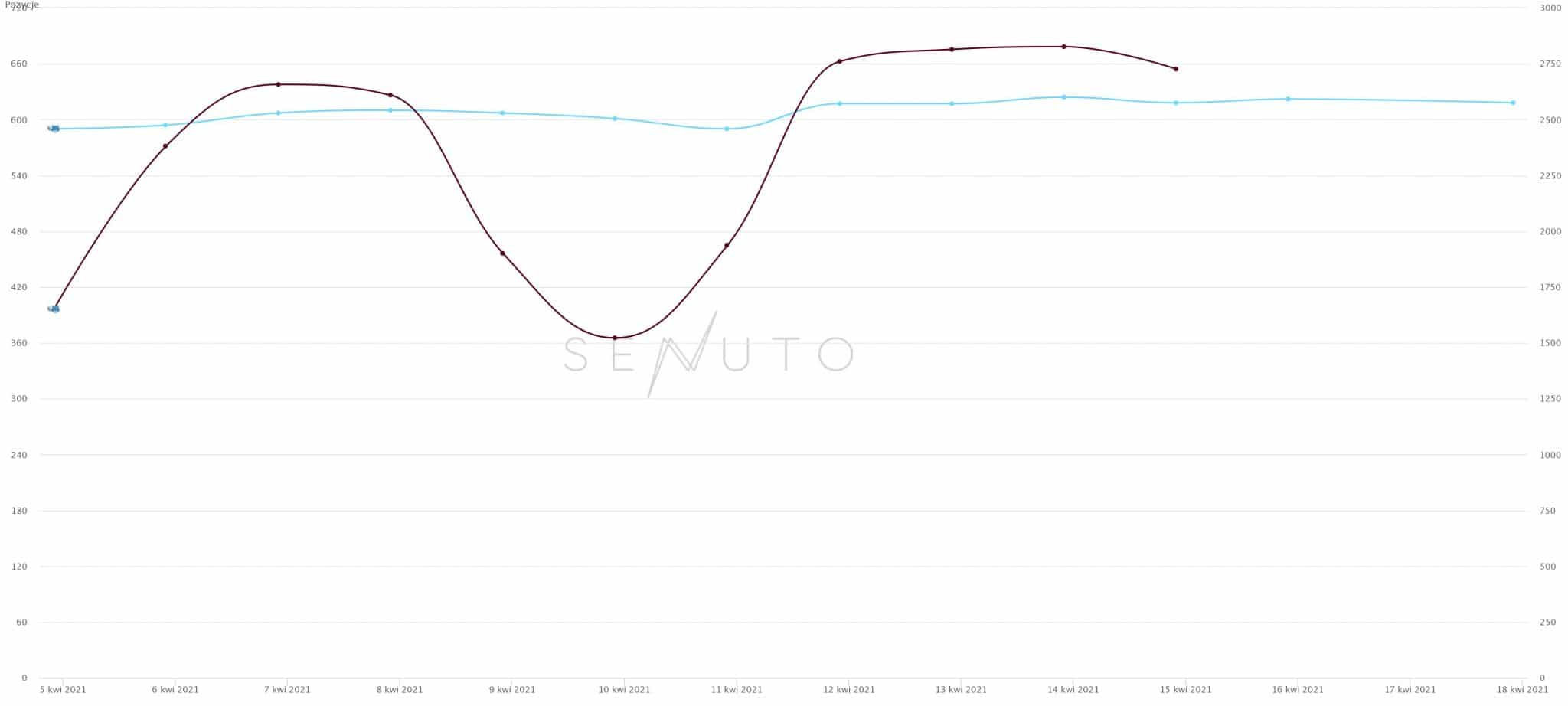

Taka integracja daje możliwość dokładniejszej oceny wpływu zmiany widoczności w TOP3 lub TOP10 na zmianę ruchu.

Te dwie metryki nie zawsze są bowiem skorelowane:

- Przesunięcie wielu fraz z TOP1 na TOP3 będzie miało duży wpływ na spadek ruchu, a nie będzie to widoczne na wykresie

- Mocny spadek widoczności w TOP10 czy TOP50 nie musi oznaczać mocnego spadku ruchu, bo mogły spaść frazy z niskim CTR

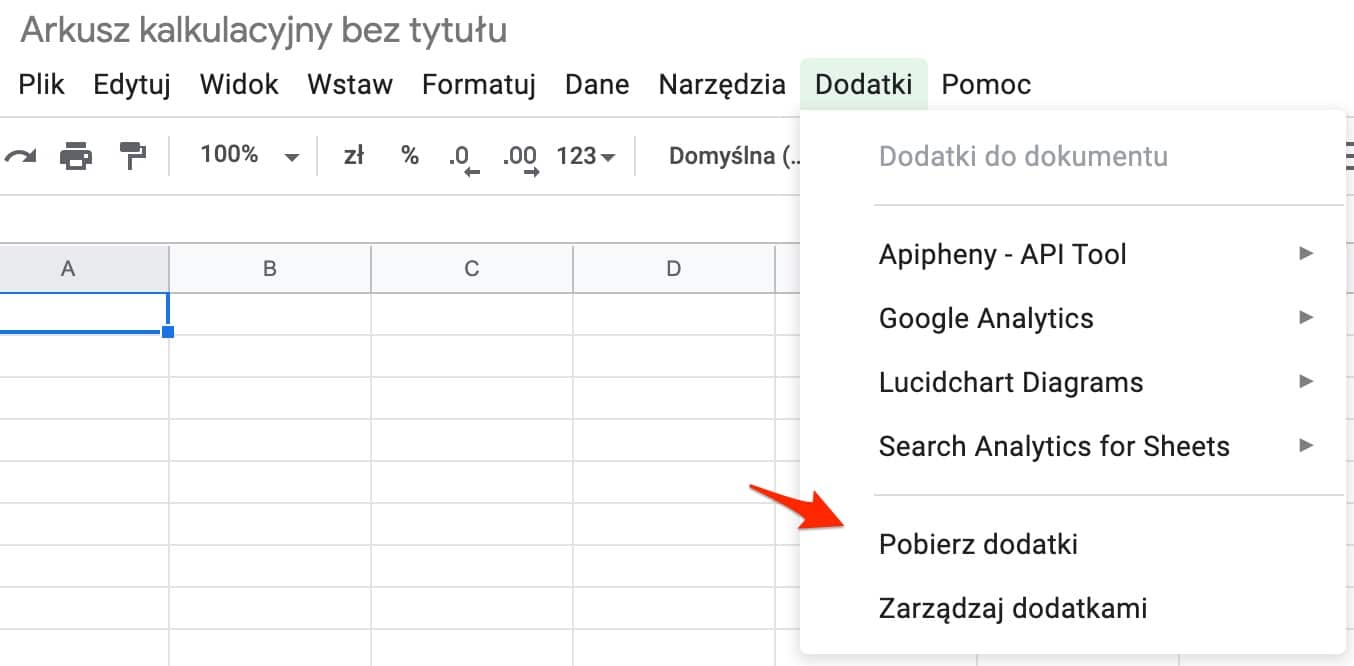

Dodatki do Google Docs

Funkcjonalności Google Docs mogą być poszerzane dzięki dodatkom. Dane z Google Search Console pobierzesz m.in. dzięki:

- Search Analytics for Sheets – https://searchanalyticsforsheets.com/

- Supermetrics – https://supermetrics.com/

Żeby pobrać dany dodatek wystarczy wejść w dowolny arkusz kalkulacyjny i z menu Dodatki wybrać opcję Pobierz dodatki, a następnie odszukać konkretną nazwę.

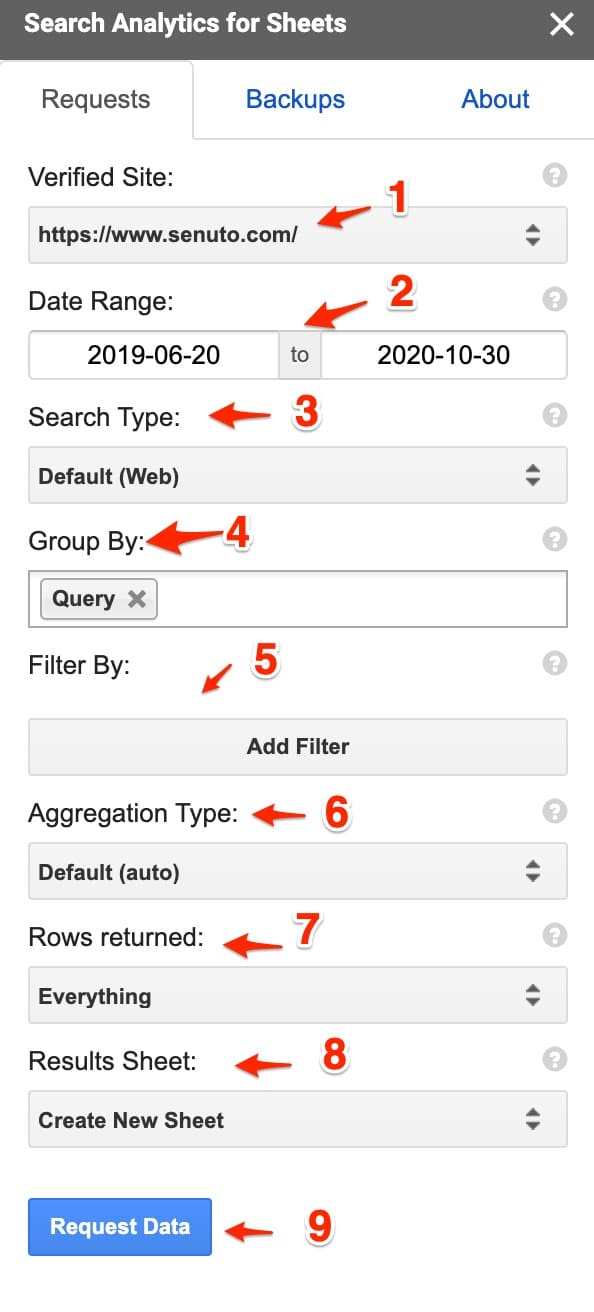

Najważniejsze zastosowania opisuję na podstawie Search Analytics for Sheets, gdyż to właśnie tej wtyczki aktywnie używam. Podobne efekty można osiągnąć w Supermetrics.

Tworzenie raportów danych

Po pobraniu wtyczki, aby ją aktywować musimy wybrać z menu Dodatki opcję Search Analytics for Sheets i kliknąć Open Sidebar.

Naszym oczom ukaże się wtedy panel konfiguracyjny raportów.

Wygląda skomplikowanie, ale prawie każda z opcji jest tu odpowiednikiem panelu w GSC.

Po kolei:

- Lista usług, dla których dane możemy pobierać

- Zakres dat, niestety nie mamy do wyboru predefiniowanych zakresów (7 dni, 28 dni), musimy podać zakres w formie daty początkowej i końcowej

- Odpowiednik filtra Typ wyszukiwania (Sieć, Grafika, Wideo, Wiadomości)

- Wymiary, które mają się pojawić w raporcie (czyli Zapytania, Strony, Kraje, Urządzenia, Wygląd w wynikach wyszukiwania), można wybrać więcej niż 1!

- Możliwość filtrowania danych

- Typ agregowania danych – zostawiamy jako default

- Liczba wierszy jakie mają być zwrócone, do wyboru 1000, 5000 lub wszystkie dostępne

- Miejsce, w którym mają się pojawić dane – aktualny arkusz (nadpisze wtedy dane, jeśli jakieś są) lub nowy arkusz

- Pobieranie danych.

Pobierając raport z konfiguracją taką jak na powyższym screenie dostaniemy listę wszystkich fraz, które dały wejścia w ostatnich 16 miesiącach.

Jaka będzie główna różnica w porównaniu z klasycznym raportem w GSC lub eksportem danych? Odpowiedź brzmi: ilość danych.

W GSC lub eksporcie danych z GSC dostaniemy infomację o 1000 pierwszych zapytań, z kolei pobierając dane w ten sposób mamy listę 50 000 zapytań! To aż 50x więcej.

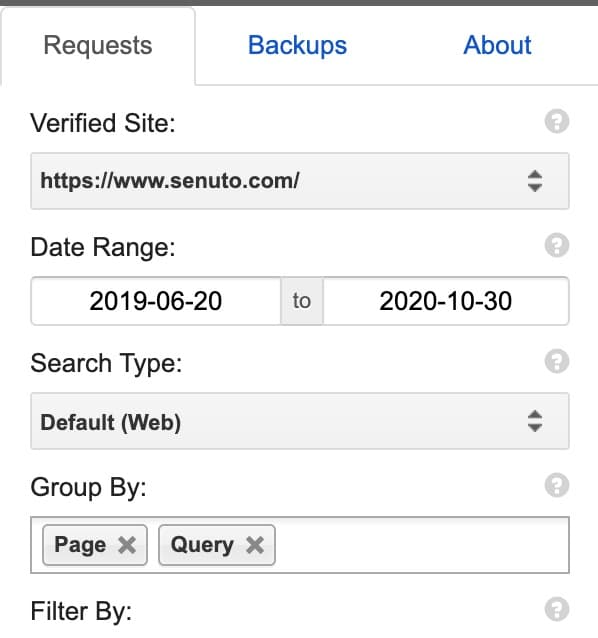

Tworzenie raportów danych korzystając z 2 wymiarów

Jeszcze dokładniejsze dane uzyskamy, pobierając raport złożony z 2 wymiarów, a konkretnie strona + zapytanie.

Potrzebna jest tylko drobna zmiana w konfiguracji raportu:

Konfiguracja raportu z 2 wymiarów

W efekcie dostaniemy dane nie tylko o zapytaniach, ale także stronach docelowych, na które trafiają użytkownicy po wpisaniu danej frazy.

Tego typu raport daje nam już dużo większe możliwości analizy, przede wszystkim możemy sprawdzić, czy użytkownicy wpisujący określone słowa kluczowe trafiają na odpowiednie podstrony.

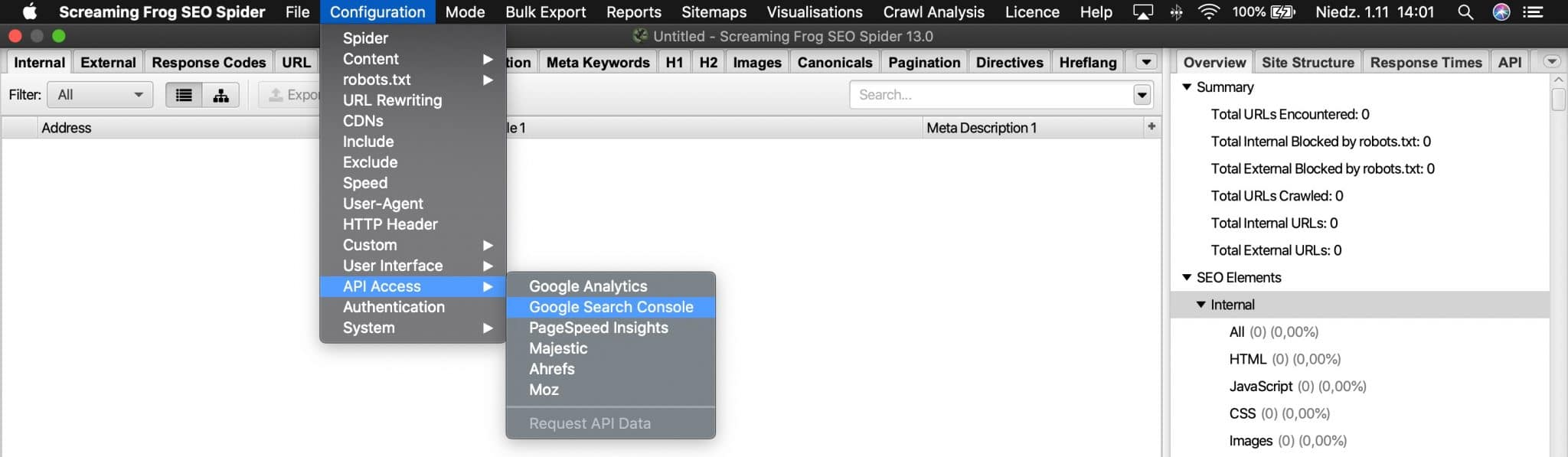

Integracja GSC i SF

Screaming Frog to jeden z popularnych crawlerów używanych do audytów technicznych. Wykonując crawl serwisu mamy możliwość zestawienia danych z crawla z danymi z GSC.

Łączenie różnych źródeł danych zawsze pozwala na uzyskanie pełniejszego obrazu sytuacji i ułatwia podejmowanie decyzji.

Podłączenie GSC do Screaming Froga jest bardzo proste. W menu trzeba wybrać opcję Configuration, następnie API Access i Google Search Console.

Połączenie kont sprowadza się do zalogowania się na nasze konto Google, pod którym mamy dostęp do usług GSC.

Po połączeniu usług warto ustawić też zakres czasu, dla którego mają być pobrane dane.

Co nam to daje?

- Dane na temat każdego adresu URL są wzbogacone o dane z GSC (Clicks, Impressions, Position, CTR)

- Mamy możliwość analizowania korelacji, np. między linkowaniem wewnętrznym a liczbą kliknięć

- Dostajemy w SF dodatkowy raport Search Console, gdzie adresy URL są pogrupowane wg 4 kategorii:

- Clicks Above 0 – podstrony, które zanotowały jakiekolwiek wejścia

- No GSC data – strony, które nie zanotowały żadnych wejść

- Non-Indexable with GSC Data – podstrony, które są wyłączone z indeksacji, a mimo to rejestrują wejścia, warto się przyjrzeć i odnaleźć przyczyny takiej sytuacji

- Orphan URLs – adresy URL, które odnotowują wejścia, ale nie są nigdzie podlinkowane na stronie, tego typu podstrony powinniśmy jak najszybciej podlinkować ze strony, ponieważ mają potencjał na uzyskanie jeszcze większego ruchu

Analiza danych o skuteczności

Niewątpliwym plusem danych, które znajdziemy w GSC jest ich pochodzenie – dane od źródła, czyli wyszukiwarki Google.

Warto z tego faktu korzystać i dane te jak najszerzej wykorzystać.

W jaki sposób można analizować dane o skuteczności w GSC:

- Badanie CTR – dzięki takim danym jesteś w stanie oszacować, jak wyglądają CTRy dla każdej z pozycji dla Twojej witryny, w zależności od branży i wykorzystywanych snippetów różnice mogą być znaczne

- Poszukiwanie słów quick wins – słowa z pozycji 11-14, dla których lekkie podbicie pozycji może przełożyć się na duży wzrost ruchu

- Analiza nowych słów kluczowych – część ze słów kluczowych, po których użytkownicy odnajdują Twoją stronę to zupełnie nowe słowa, wpisywane po raz pierwszy

- Badanie jaka część ruchu to ruch brandowy – czyli wejście ze słów, które są nazwą Twojego brandu, ale też słowa, które zawierają brand, np. senuto blog, senuto badanie zarobków, senuto badanie ctr

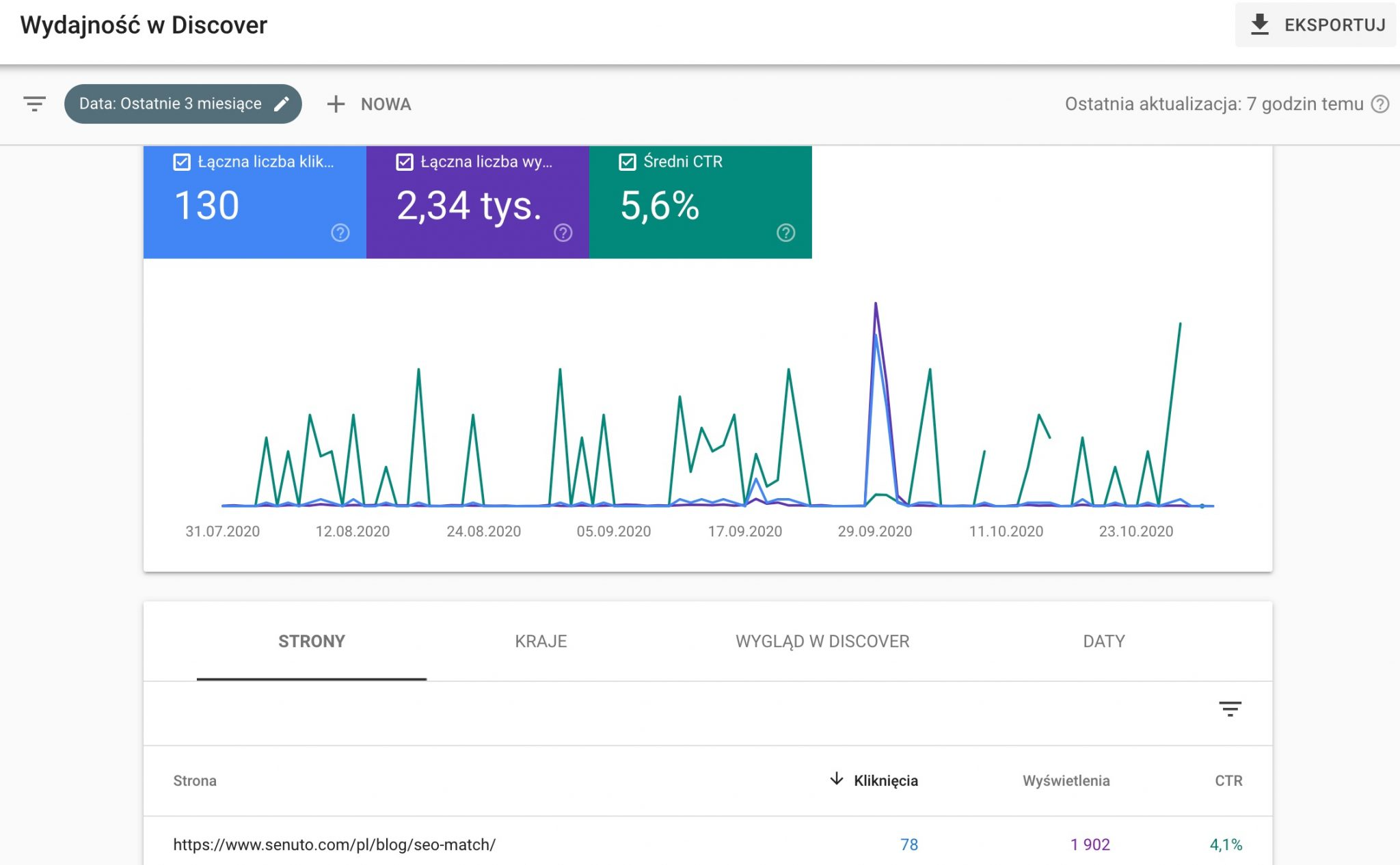

Raport Discover

Jeśli Twoja witryna wyświetla się w usłudze Discover, to w GSC będziesz mieć widoczny dodatkowy raport o nazwie Discover.

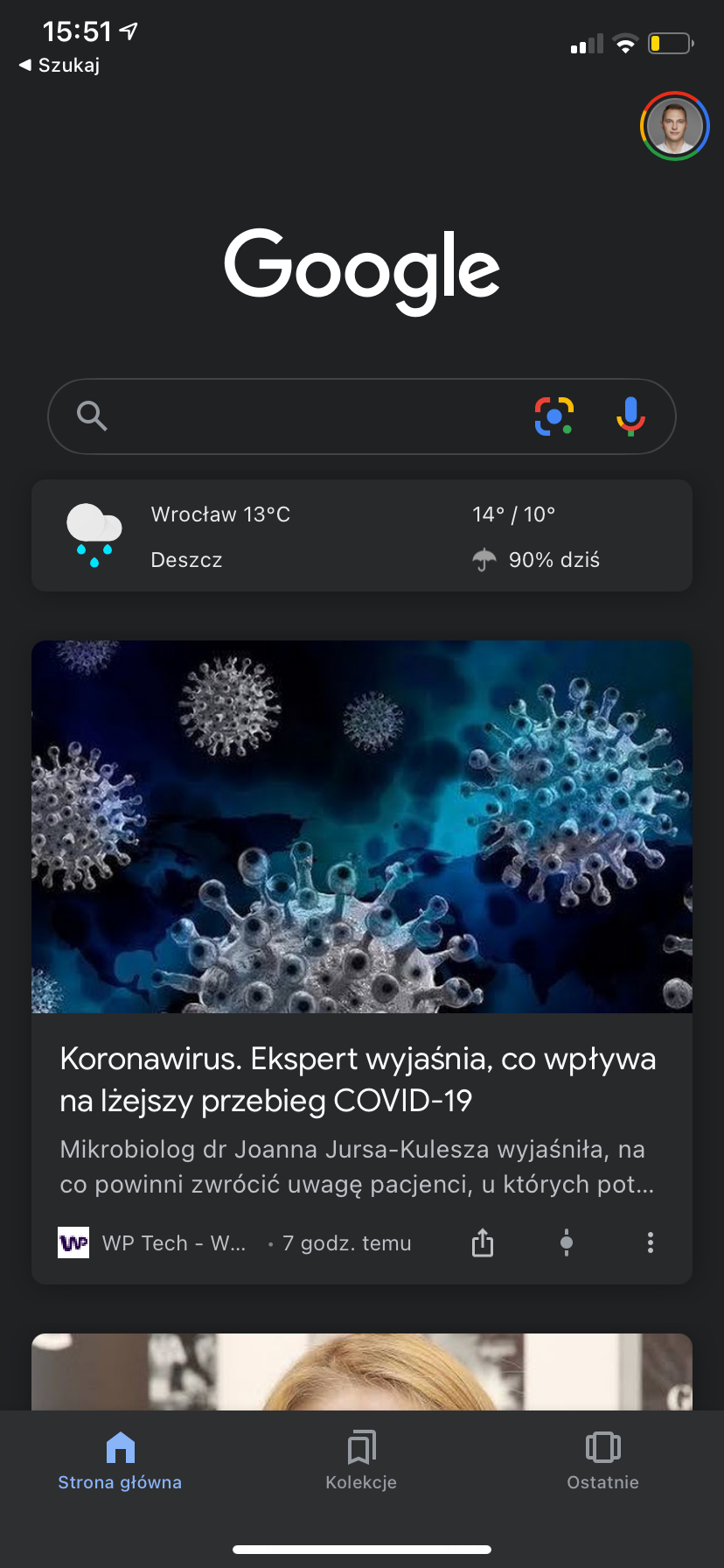

Czym jest Google Discover?

Jest to dodatkowa usługa od Google, która podpowiada użytkownikom treści na podstawie ich zainteresowań oraz historii wyszukiwania i odwiedzonych wcześniej witryn.

W zamyśle mają to być treści, które powinny interesować danego użytkownika. Treści są mocno spersonalizowane, więc każdy powinien dostać podpowiedzi dopasowane do siebie.

Gdzie pojawia się Google Discover?

Sugestie treści występują w kilku miejscach:

- Aplikacja mobilna Google na iOS

- Aplikacja mobilna Google na Androida

- Aplikacja mobilna Google Chrome na iOS

- Aplikacja mobilna Google Chrome na Androida

W takim listingu wyników można się doszukać pewnych analogii do wyników wyszukiwania – jakaś część użytkowników wyświetli dany wynik, jakaś część kliknie, można więc wyliczyć CTR. Stąd też obecność raportu nt. wydajności z Google Discover w Google Search Console.

Dane o skuteczności w Google Discover

Raport Wydajność w Discover wygląda w ten sposób. W stosunku do raportu dotyczącego wyszukiwarki nie znajdziemy tu:

- Danych o zapytaniach, ponieważ nie są wykonywane żadne zapytania, a treść jest serwowana użytkownikom

- Danych o pozycji, których po prostu Google nie przekazuje ze względu na silną personalizację treści w Discover

Mamy więc do analizy tylko 3 metryki: kliknięcia, wyświetlenia i CTR. To i tak cenne informacje do analizy, szczególnie że CTR jest prawdopodobnie istotnym czynnikiem decydującym o sukcesie w Google Discover.

Szczególnie w przypadku większych witryn newsowych, które dużo częściej pojawiają się w Discover, ilość danych do analizy jest pokaźna:

Raport Wiadomości

Analogicznie jak w przypadku raportu Discover, również raport Wiadomości występuje tylko w przypadku, gdy dana witryna występuje w wynikach Wiadomości.

Przy czym należy podkreślić, o które “Wiadomości” tu chodzi:

W GSC zobaczymy wyniki z zakładki “Wiadomości”, a nie z elementu “Najważniejsze wiadomości”.

Indeks

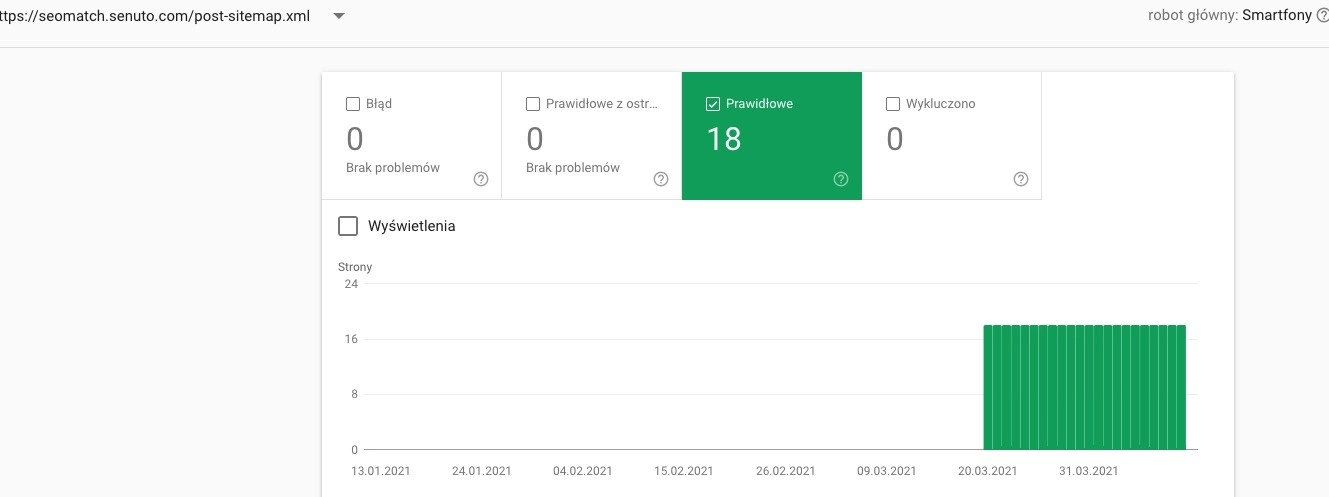

Kolejna grupa raportów związana jest ściśle z indeksacją witryny w wyszukiwarce Google. Informacje pojawiające się w tym raporcie są podobne do tych, które mogliśmy zobaczyć w raporcie Sprawdź adres URL, jednakże tu działa to w drugą stronę. Adresy URL są pokategoryzowane wg różnych stanów indeksacji.

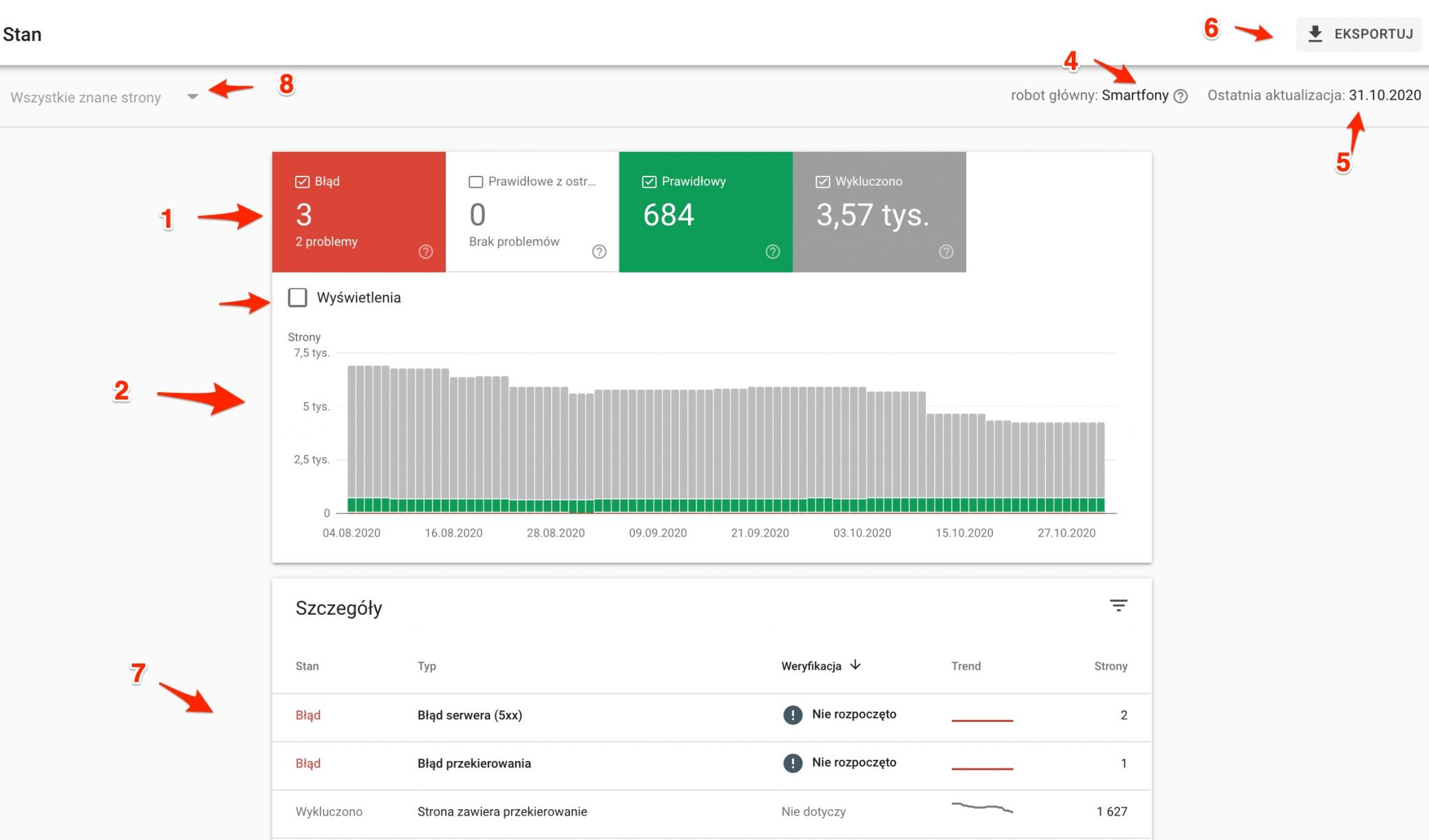

Stan

Podstawowy raport związany z indeksacją to Stan. Dane, które w tym miejscu znajdziemy są dobrym odzwierciedleniem indeksacji witryny w Google.

Najważniejsze elementy raportu przedstawiłem na poniższym zrzucie ekranu:

1 – Liczba adresów URL przypisanych do kolejnych kategorii stanu indeksacji (Błąd, Prawidłowy z ostrzeżeniem, Prawidłowy, Wykluczono)

2 – Wykres przedstawiający rozkład liczby adresów URL dla każdej z kategorii w czasie

3 – Możliwość nałożenia liczby wyświetleń na wykres, dzięki czemu możemy od razu badać związek między wzrostem jakichś problemów z indeksacją a widocznością naszej witryny

4 – Typ robota, który jest głównym skanującym naszą witrynę. W większości przypadków będzie to już robot na smartfony

5 – Ostatnia aktualizacja danych

6 – Eksport danych

7 – Szczegóły danych, adresy URL są tu sklasyfikowane na jeszcze dokładniejsze kategorie

8 – Przełącznik widoku, daje możliwość analizy tylko adresów URL z danej sitemapy

Znaczenie poszczególnych grup

W idealnej sytuacji wszystko powinno być ”na zielono”, tzn. wszystkie adresy URL powinny być indeksowane jako prawidłowe.

Jednakże ideały nie istnieją, więc powinniśmy dążyć do:

- Eliminacji adresów URL z błędami indeksacji

- Pozbycia się przyczyn ostrzeżeń przy indeksacji

- Jak najmniejszej liczby adresów URL wykluczonych z indeksacji (głównie jeśli mamy większą witrynę, np. +100k URLi, gdyż wtedy istotny zaczyna być budżet crawlowania)

Poniżej omawiamy już bardziej szczegółowo różne kategorie stanów indeksacji.

Błąd

Adresy URL z tej kategorii nie są obecnie zaindeksowane w Google. Powody tego mogą być różne.

Często wśród nazw błędów przewija się sformułowanie “przesłany adres URL”. Oznacza to, że dany adres URL został znaleziony przez roboty Google w mapie witryny (albo dzięki zgłoszeniu jej w narzędziu Mapy witryny w GSC albo przez wskazanie takiej sitemapy w pliku robots.txt).

Błąd serwera (5xx)

Powodem braku indeksacji są błędy serwera. Warto zbadać kiedy dokładnie te problemy występowały, jakich adresów URL dotyczyły i skontaktować się z administratorem serwera, na którym jest hostowana nasza strona.

Błąd przekierowania

Ten błąd może wystąpić w kilku przypadkach: zbyt długi łańcuch przekierowań lub pętla przekierowań. Do sprawdzenia przyczyny możesz wykorzystać np. narzędzie: https://httpstatus.io/

Przesłany URL jest zablokowany przez plik robots.txt

Adresy URL z tej grupy zostały przesłane do zaindeksowania (przez mapę witryny), ale nie mogły być zaindeksowane, ponieważ uniemożliwiają to reguły w pliku robots.txt.

Jeśli nie było to Twoim zamiarem, przetestuj aktualne reguły z pliku robots.txt w narzędziu tester pliku robots.txt i popraw je tak, aby dany adres mógł być zaindeksowany.

Jeśli dany adres nie powinien być indeksowany, należy go wykluczyć z mapy witryny.

Przesłany URL zawiera tag „noindex”

Adres URL został przesłany do zaindeksowania przez sitemapę, ale w kodzie ma znacznik noindex, który tę indeksację blokuję.

Rozwiązaniem będzie usunięcie takiego adresu z sitemapy lub usunięcie znacznika noindex.

Przesłany adres URL wydaje się zgłaszać pozorny błąd 404

Błąd wystąpi, kiedy adres URL, który wygląda na niedziałający (np. brak treści) zwraca kod HTTP 200 (czyli poprawne działająca strona).

Przesłany URL zwraca błąd z powodu nieautoryzowanego żądania (401)

Adres URL znajdujący się w sitemapie, po którego odwiedzeniu roboty otrzymują kod odpowiedzi 401 – brak autoryzacji.

Rozwiązanie to poprawienie dostępu do danej podstrony dla Googlebota. Wytyczne dotyczące tego jak poprawnie weryfikować Googlebota: https://support.google.com/webmasters/answer/80553

Nie udało się odnaleźć przesłanego URL-a (404)

W mapie XML znajduje się adres URL z kodem błędu 404.

Należy albo zweryfikować i poprawić występowanie błędu, albo taki adres usunąć z sitemapy.

Prawidłowe z ostrzeżeniami

Strona zindeksowana, ale zablokowana przez plik robots.txt

Pomimo tego, że dana podstrona jest zablokowana przed indeksacją za pomocą pliku robots.txt, to i tak została zaindeksowana. Dzieje się tak głównie w przypadku, jeśli roboty znajdują link do danej podstrony na innych serwisach. W takim wypadku warto przemyśleć, czy dany adres URL na pewno powinien być blokowany w robots.

Prawidłowe

Adresy URL z tej grupy są zaindeksowane w wynikach wyszukiwania.

Strona przesłana i zindeksowana

Adresy URL zostały poprawnie zaindeksowane i są zgłoszone w mapie witryny.

Strona zindeksowana, ale nie przesłana w mapie witryny

Adresy URL zostały zaindeksowane, choć nie zgłoszono ich w mapie witryny.

Warto przejrzeć listę tych adresów i zbadać, czy nie powinny były się w takiej sitemapie znaleźć.

Wykluczono

Podstrony w tych kategoriach nie są zaindeksowane w Google z różnych powodów. Część z nich może być wykluczeniem z indeksu zgodnie z naszą intencją, a część z powodu błędów.

Strona wykluczona za pomocą tagu „noindex”

Adresy URL w tej grupie nie są zaindeksowane, ze względu na umieszczenie w kodzie HTML znacznika meta robots z atrybutem noindex. Czyli jasne wskazanie, że tej strony nie chcemy indeksować.

Strona zablokowana przez narzędzie do usuwania stron

Strony wykluczone z indeksu ręcznie, za pomocą narzędzia do usuwania adresów URL. Więcej o tym narzędziu w dalszej części artykułu. Usunięcie adresów URL z indeksacji w ten sposób jest skuteczne przez około 90 dni.

Strona zablokowana przez plik robots.txt

Roboty Google nie zaindeksowały takich adresów URL, ponieważ uniemożliwia to plik robots.txt. Blokowanie przez robots.txt może być nieskuteczne, jeśli linki do danej podstrony występują na innych serwisach. W takim przypadku adresy URL zostaną umieszczone w innej grupie (wśród błędów w kategorii Przesłany URL jest zablokowany przez plik robots.txt)

Strona zablokowana z powodu nieautoryzowanego żądania (401)

Dostęp do stron został zablokowany z powodu błędu 401 – dostęp wymaga autoryzacji, która nie została udzielona. Z tego powodu dana strona została wykluczona z indeksu.

Strona zeskanowana, ale jeszcze nie zindeksowana

Roboty Google zeskanowały dany adres URL (cały proces indeksacji w Google to w skrócie: odkrywanie, skanowanie, indeksowanie), lecz jeszcze go nie zaindeksowały.

Zwykle wystarczy odczekać, by adres URL został zaindeksowany. Warto jednak sprawdzić, czy strony przypisane do tej kategorii nie podpadają pod thin content.

Strona wykryta – obecnie nie zindeksowana

Roboty miały dane strony w kolejce do zaindeksowania, ale nie zdołały tego zrobić. Przyczyną tego mogło być np. wolniejsze działanie strony w danym czasie.

Alternatywna strona zawierająca prawidłowy tag strony kanonicznej

Adresy URL w tej kategorii nie są zaindeksowane zgodnie z oznaczeniem w znaczniku rel canonical, że dany adres URL jest duplikatem innej strony – kanoniczej.

Duplikat, użytkownik nie oznaczył strony kanonicznej

Według oceny mechanizmu indeksowania, ta strona jest duplikatem innej i jednocześnie nie wskazano przez znacznik rel canonical, jakiej konkretnie.

Za pomocą narzędzia sprawdzania adresu URL sprawdzisz, jaka strona została wskazana przez roboty jako kanoniczna.

Duplikat, wyszukiwarka Google wybrała inną stronę kanoniczną niż użytkownik

Adresy URL w tej kategorii nie są indeksowane, ponieważ są duplikatami. Oznaczono to przez znaczniki rel canonical, jednak roboty Google oceniły, że kanoniczną jest inna strona niż wskazano.

Skorzystaj z narzędzia sprawdzania adresu URL aby zweryfikować ten problem.

Nie znaleziono (404)

Roboty Google trafiły na adres URL, które zostały już usunięte (błąd 404) prawdopodobnie na innej stronie.

Nie mamy wpływu na linki na innych stronach, pozostaje więc albo zostawić dany status 404, albo przekierować adres URL na jakiś inny.

Strona usunięta w wyniku skargi prawnej

Wskazane strony zostały usunięte ze względów prawnych (ktoś dokonał zgłoszenia). Mogło to być związane z publikacją danych osobowych lub kwestią praw autorskich.

Strona zawiera przekierowanie

Dane adresy URL są przekierowywane na inne, więc nie będą indeksowane. Jeśli linki do takich stron występują wewnętrznie, to warto je zaktualizować.

Pozorny błąd 404

Strony w tej kategorii powinny zwracać błąd 404, tymczasem działają jako normalne strony (status 200).

Duplikat, przesłany URL nie został oznaczony jako strona kanoniczna

Roboty wyszukiwarki uznały dany adres URL jako duplikat innego, przy czym w kodzie nie oznaczono adresu kanonicznego. Sytuacja taka może mieć miejsce np. w przypadku stron z bardzo małą ilością treści.

Mapy witryny

Ta grupa raportów służy do analizy map witryny. Dodając mapę witryny przez GSC zyskujemy możliwość sprawdzenia, ile adresów z sitemapy jest indeksowanych, a ile nie i z jakiego powodu.

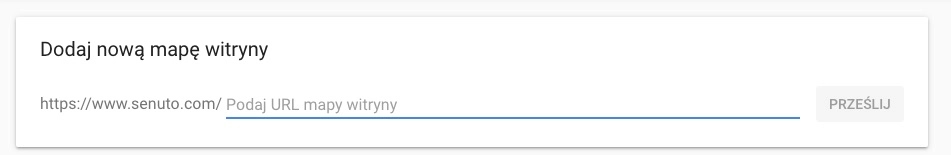

Zgłaszanie mapy witryny

Dodanie mapy witryny do ich późniejszej analizy sprowadza się do wskazania jej adresu URL:

Do czasu przetworzenia danych z sitemapy może minąć kilka dni.

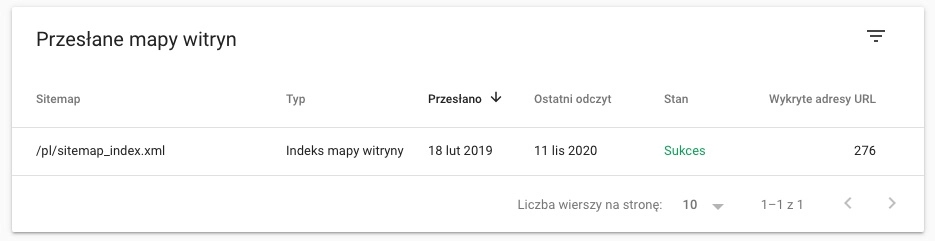

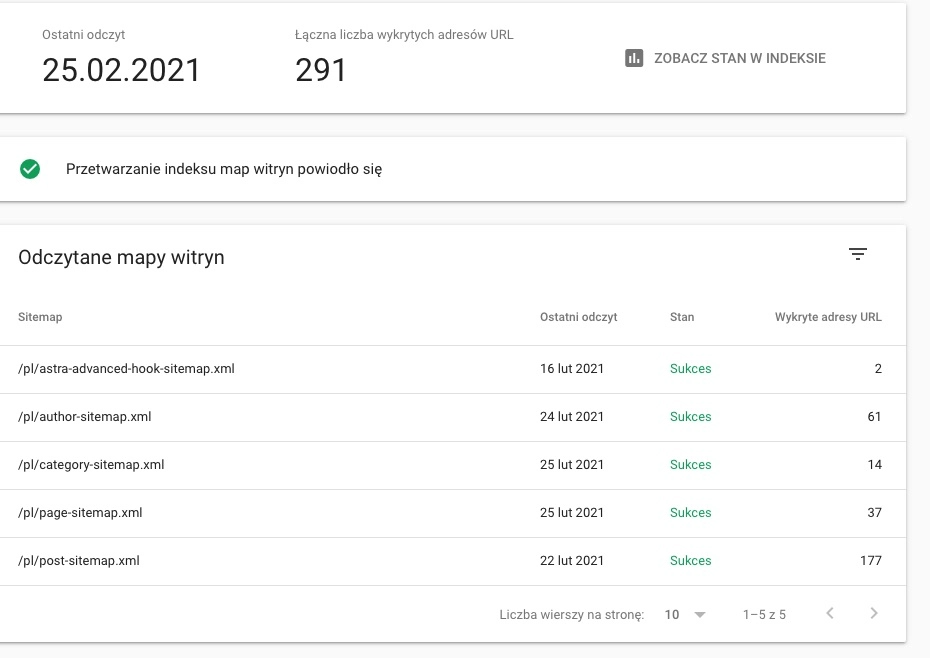

Przegląd map witryny

Tak wygląda ten raport dla Senuto.

GSC obsługuje zarówno indeksy mapy witryny, jak i same mapy witryny.

W przypadku, jeśli dodawaliśmy mapę witryny, w GSC zobaczymy taki widok:

Po kliknięciu w mapę witryny widok szczegółowy, dodatkowo widzimy liczbę adresów URL wykrytych w każdej mapie:

Analizowanie mapy witryny

Dodane mapy witryn są sporym ułatwieniem do analizy indeksacji, szczególnie jeśli podział na sitemapy jest zgodny ze strukturą serwisu (np. osobna sitemapa na kategorie, osobna na artykuły). Jeśli witryna ma problemy z indeksacją, łatwiej będzie je w ten sposób można zdiagnozować.

Na przykładzie poniżej, dane z raportu Stan są ograniczone tylko do URL-i z jednej konkretnej sitemapy.

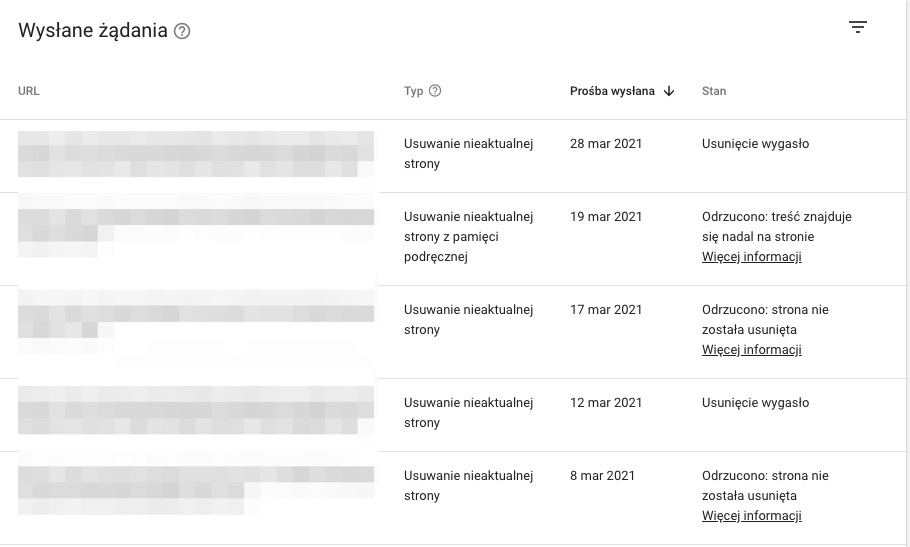

Usunięcia

W tym raporcie zebrane są prośby o usunięcie treści z Twojej witryny z wyników wyszukiwania.

Widoczne są tu 3 zakładki, każda z nich ma inne zastosowanie.

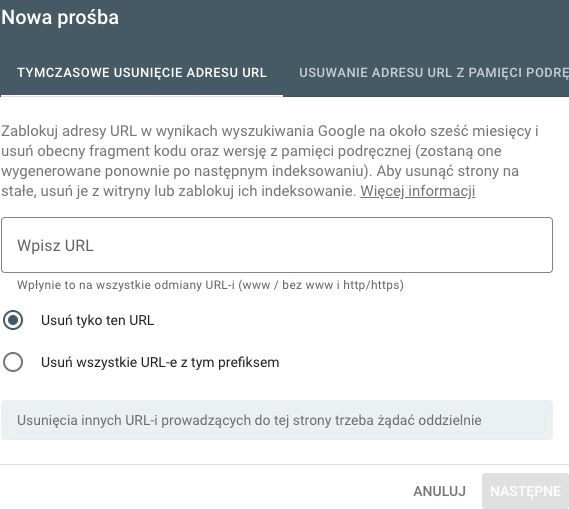

Tymczasowe usunięcia

W tym miejscu możesz sam zgłosić adresy URL, które chcesz, żeby szybko przestały się pojawiać w wynikach wyszukiwania.

Ma to zastosowanie np. jeśli pewne treści zaindeksowały się przypadkowo lub opublikowane zostały wrażliwe dane osób 3.

Nie jest to sposób na trwałe zapobieganie indeksowania tych treści! Jest to metoda skuteczna jeśli chcemy szybko ukryć treści, ale równolegle powinniśmy wykonać inne działania żeby uniknąć indeksowania kłopotliwych treści (np. zmiana meta robots na noindex, usunięcie treści).

Możesz usunąć cały prefix (np. senuto.com/forum) lub tylko wybrany adres URL.

Do wyboru mamy 2 różne tryby:

- Tymczasowe usunięcie adresu URL – dana strona zniknie na około 6 mc z wyników wyszukiwania

- Usuwanie adresu URL z pamięci podręcznej – wynik zniknie ze strony wyników wyszukiwania do momentu ponownej indeksacji tej strony

Nieaktualna treść

W tej zakładce zobaczysz zgłoszenia od innych użytkowników, wysłane przez narzędzie: https://search.google.com/search-console/remove-outdated-content

Każdy może zgłosić prośbę o usunięcie nieaktualnej treści z wyników wyszukiwania.

Uwaga!

Dotyczy to tylko i wyłącznie sytuacji, kiedy dane treści pojawiają się w wynikach wyszukiwania (np. nieaktualne dane adresowe), ale faktycznie na stronie, do której prowadzi link, zostały już usunięte lub zaktualizowane.

Nie należy więc rozumieć “nieaktualnej treści” jako niezgodnej ze stanem faktycznym, a względem tego, co na stronie.

Filtrowanie SafeSearch

Ostatnia z grup dotyczy zgłoszeń treści “tylko dla dorosłych”. Filtr SafeSearch, który ma na celu przede wszystkim chronić dzieci przed dostępem do nieodpowiednich treści, usuwa z wyników wyszukiwania wybrane elementy.

W raporcie “Filtrowanie SafeSearch” zobaczysz, jakie treści zostały zgłoszone przez innych i jaki jest wynik tego zgłoszenia.

Ulepszenia

W tej części zawarte są informacje związane z optymalizacją szybkości, optymalizacją pod urządzenia mobilne oraz dodatkowymi elementami, które rozszerzają widok naszej strony w wynikach wyszukiwania.

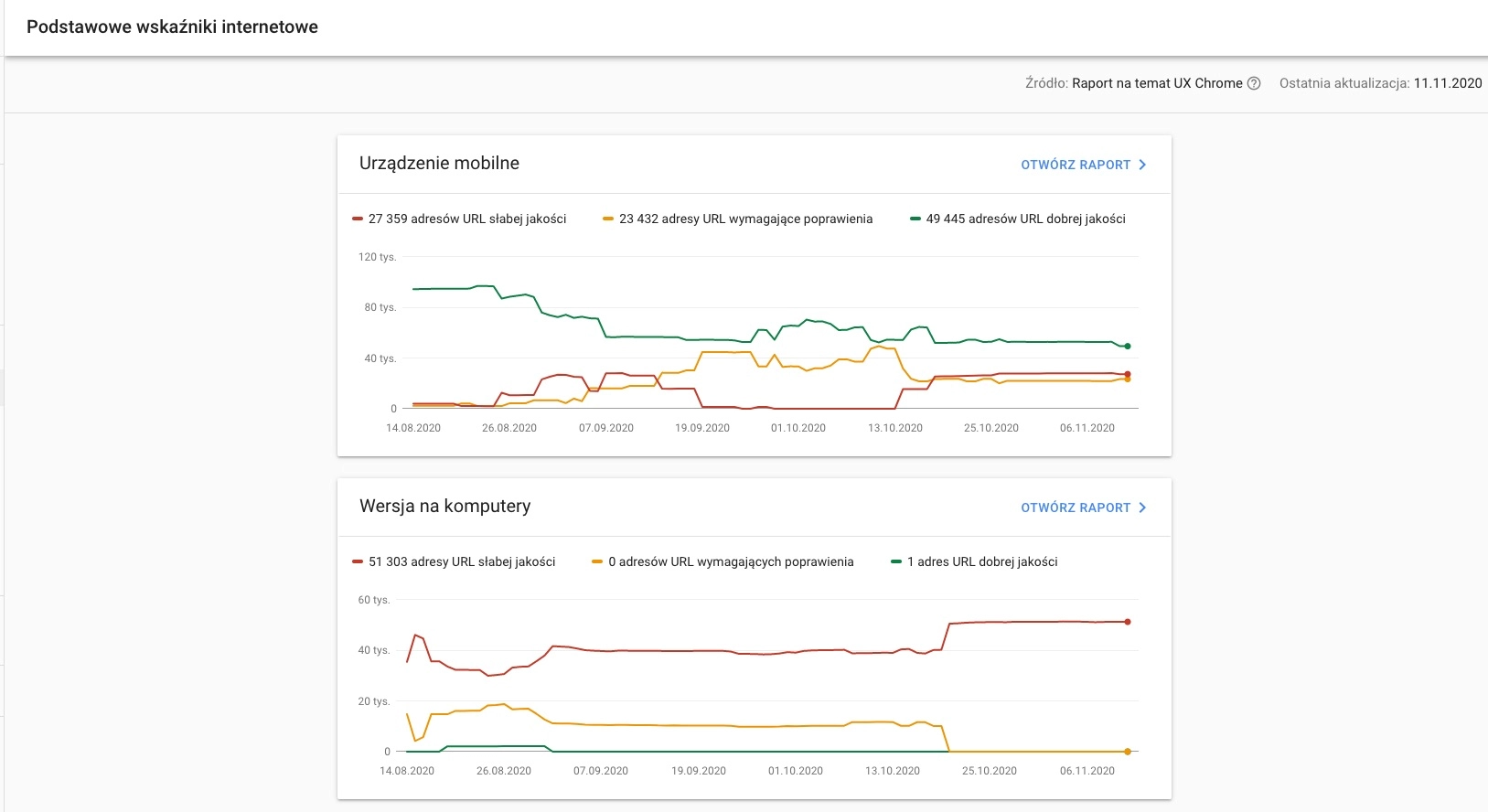

Podstawowe wskaźniki internetowe

W 2020 ustalono 3 podstawowe wskaźniki (ang. Web Vitals), które mają decydować o tym, czy strona ładuje się szybko i jest przyjazna użytkownikowi.

FID (First Input Delay) – czas potrzebny od momentu interakcji użytkownika ze stroną (kliknięcia w link, button, przycisk play, rozwinięcia schowanego tekstu), mierzone w sekundach

LCP (Largest Contentful Paint) – czas potrzebny do wyrenderowania największego elementu widocznego na ekranie, zwykle będzie to grafika, tekst lub video, mierzone w sekundach

CLS (Cumulative Layout Shift) – miara stabilności layoutu podczas ładowania strony, im częściej dochodzi do przesunięć (skakania elementów z jednego miejsca na drugie), tym współczynnik wyższy, skala to 0-1

Przeczytaj też: Core Web Vitals, czyli Podstawowe wskaźniki internetowe. 9 pytań i 23 odpowiedzi

Parametry te mierzone są na podstawie CrUX report, czyli Chrome User Experience Report. Dane pochodzą z przeglądarki Chrome, która analizuje i mierzy realnych użytkowników.

W zależności od wartości tych parametrów, adresy URL zostały sklasyfikowane na 3 kategorie:

- Dobrej jakości

- Wymagające poprawy

- Niskiej jakości

Badane adresy URL są klasyfikowane osobno dla wersji na komputery i osobno na urządzenia mobilne.

Skala, według której adresy URL są przypisywane do kategorii:

| Kategoria | FID | LCP | CLS |

| Dobra jakość | < 100 ms | < 2,5 s | < 0,1 |

| Wymagające poprawy | <= 300 ms | <= 4s | <= 0,25 |

| Niska jakość | > 300 ms | > 4s | > 0,25 |

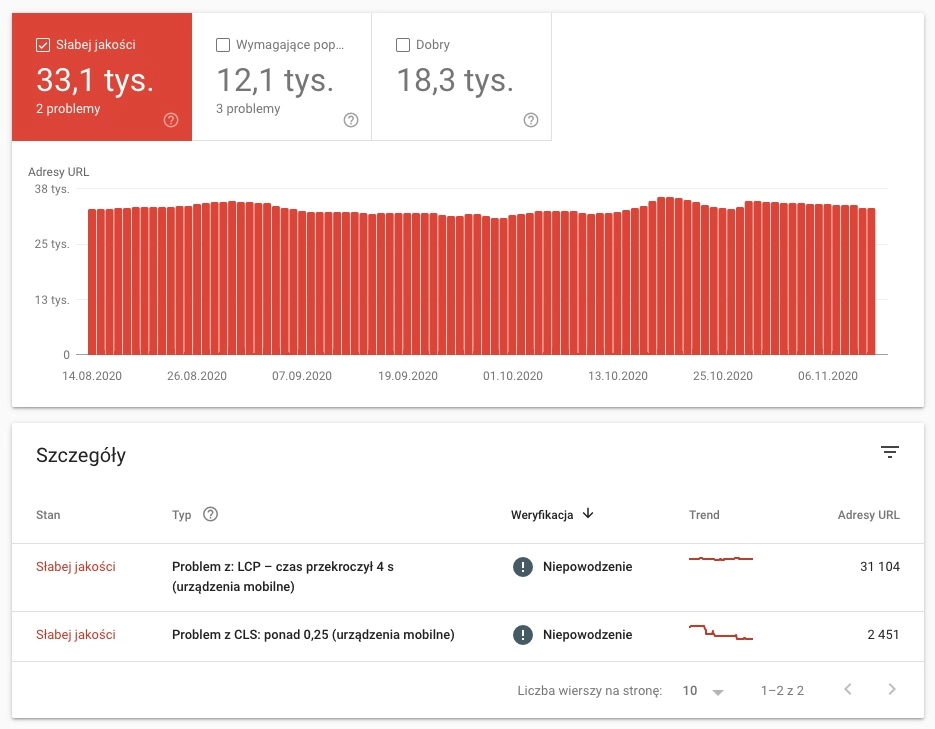

W raporcie podstawowych wskaźników znajdziemy wykres przedstawiający liczbę adresów URL przypisanych do danej kategorii i jego rozkład w czasie:

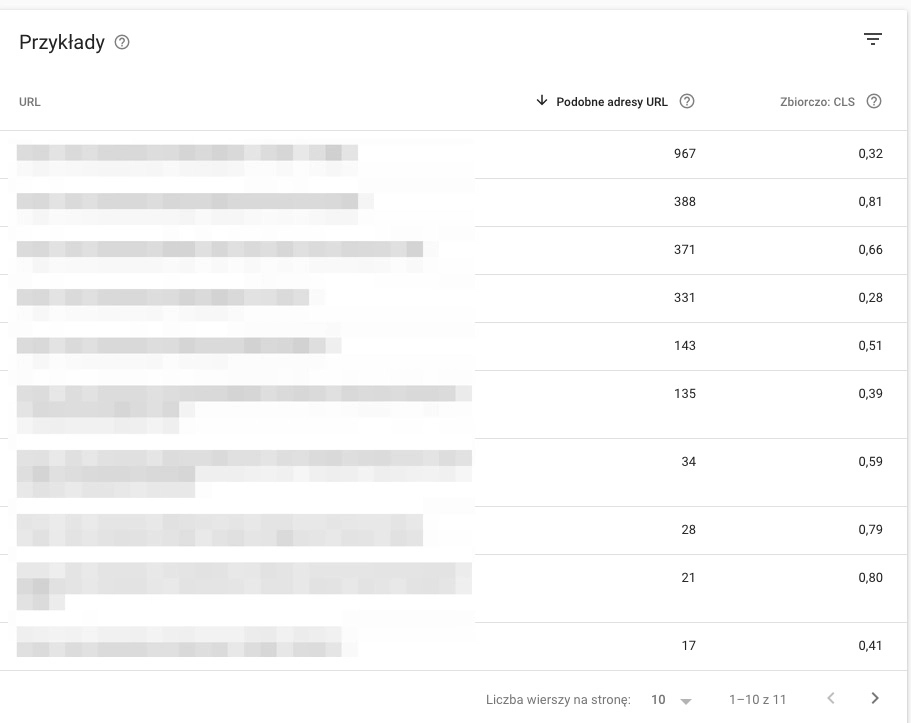

Po przejściu do bardziej szczegółowego raportu otrzymamy też informację, co konkretnie zdecydowało o przypisaniu adresu URL do danej kategorii:

W tym przypadku problemem jest CLS.

Dalsze zagłębienie się w raport (kliknięcie w konkretny problem) da nam wykaz konkretnych adresów URL, które powodują problem:

Jak widzisz występują spore grupy adresów URL, które mają takie same wyniki CLS. Wynika to z tego, że przy tym samym schemacie strony (widoku), zwykle ten wynik będzie bardzo podobny.

Do dalszego analizowania i zgłębiania problemów z podstawowymi wskaźnikami warto użyć:

- PageSpeed Insights – https://developers.google.com/speed/pagespeed/insights/?hl=pl

- WebPageTest – https://www.webpagetest.org/

- DevTools w Google Chrome

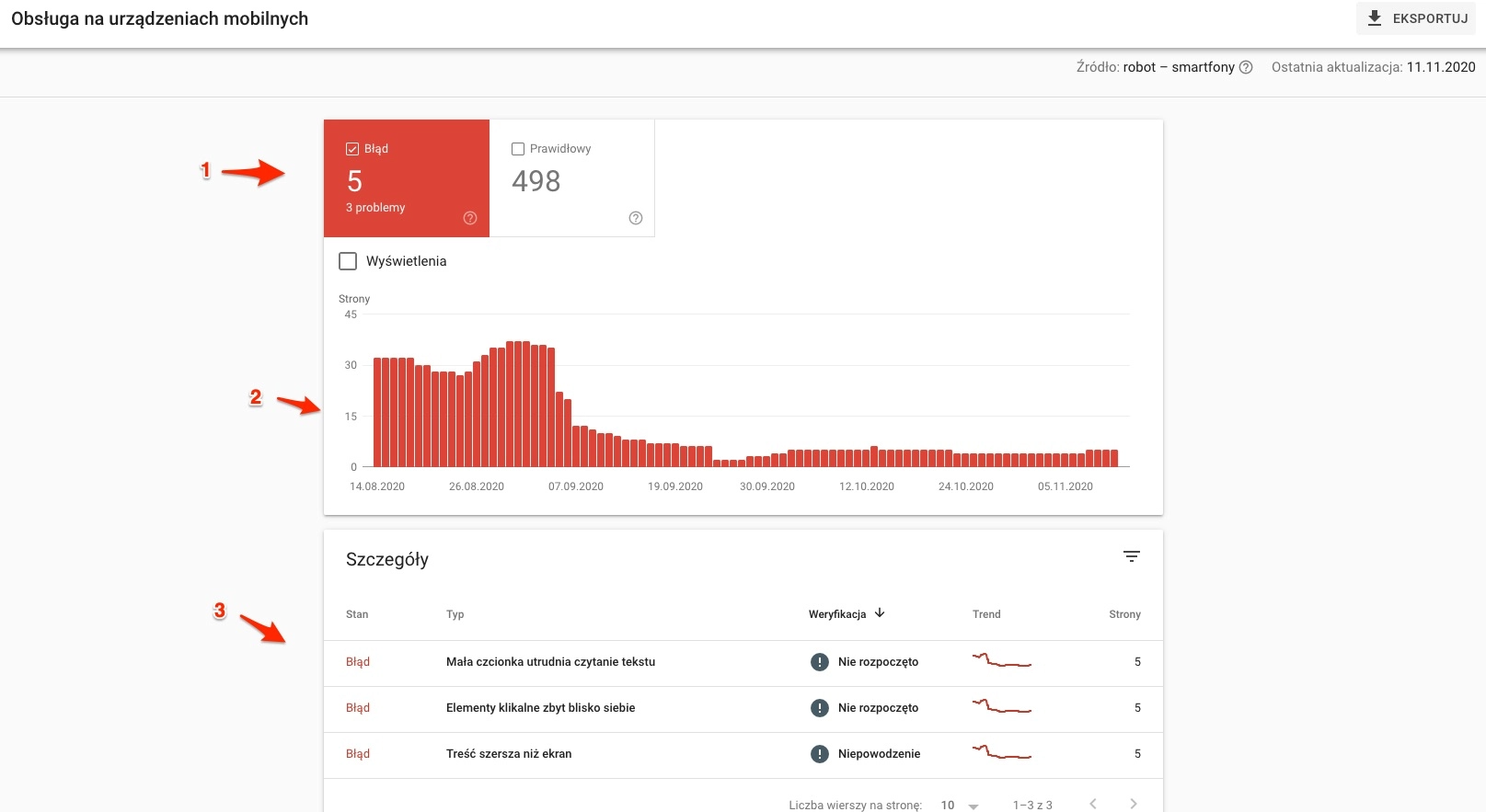

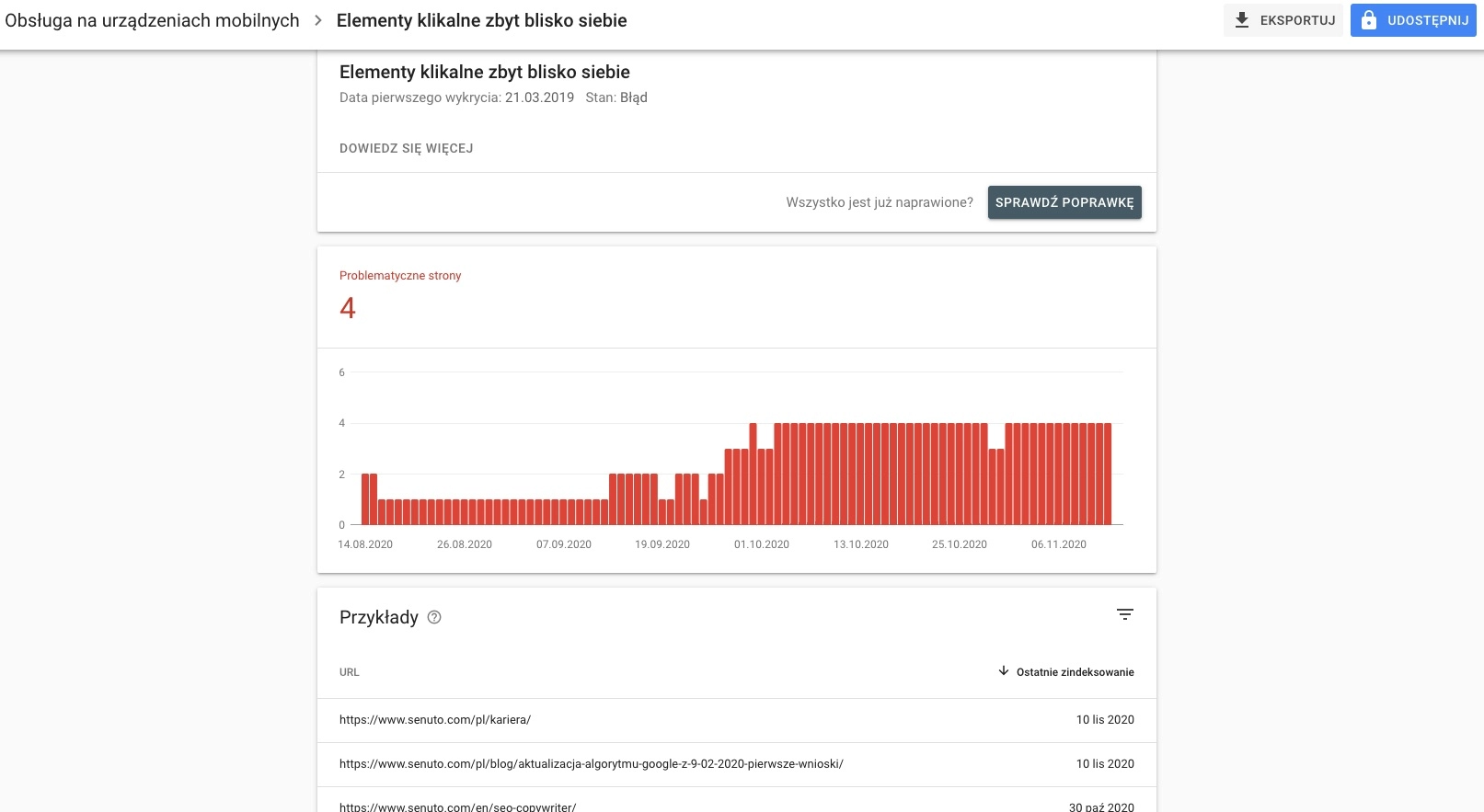

Obsługa na urządzeniach mobilnych

Ten raport skupia się na optymalizacji pod kątem urządzeń mobilnych. Podstrony są w tym przypadku sklasyfikowane na 2 sposoby:

- Prawidłowo zoptymalizowane pod kątem mobile

- Z błędami, czyli nie zoptymalizowane pod kątem mobile

Dalsze diagnozowanie powinno się wtedy odbywać za pomocą testera optymalizacji mobilnej: https://search.google.com/test/mobile-friendly?hl=pl

Elementy raportu:

1 – liczba podstron w każdej z kategorii

2 – zmiana w czasie

3 – szczegółowy podział adresów URL

Po kliknięciu w kategorię przechodzimy do bardziej szczegółowego raportu:

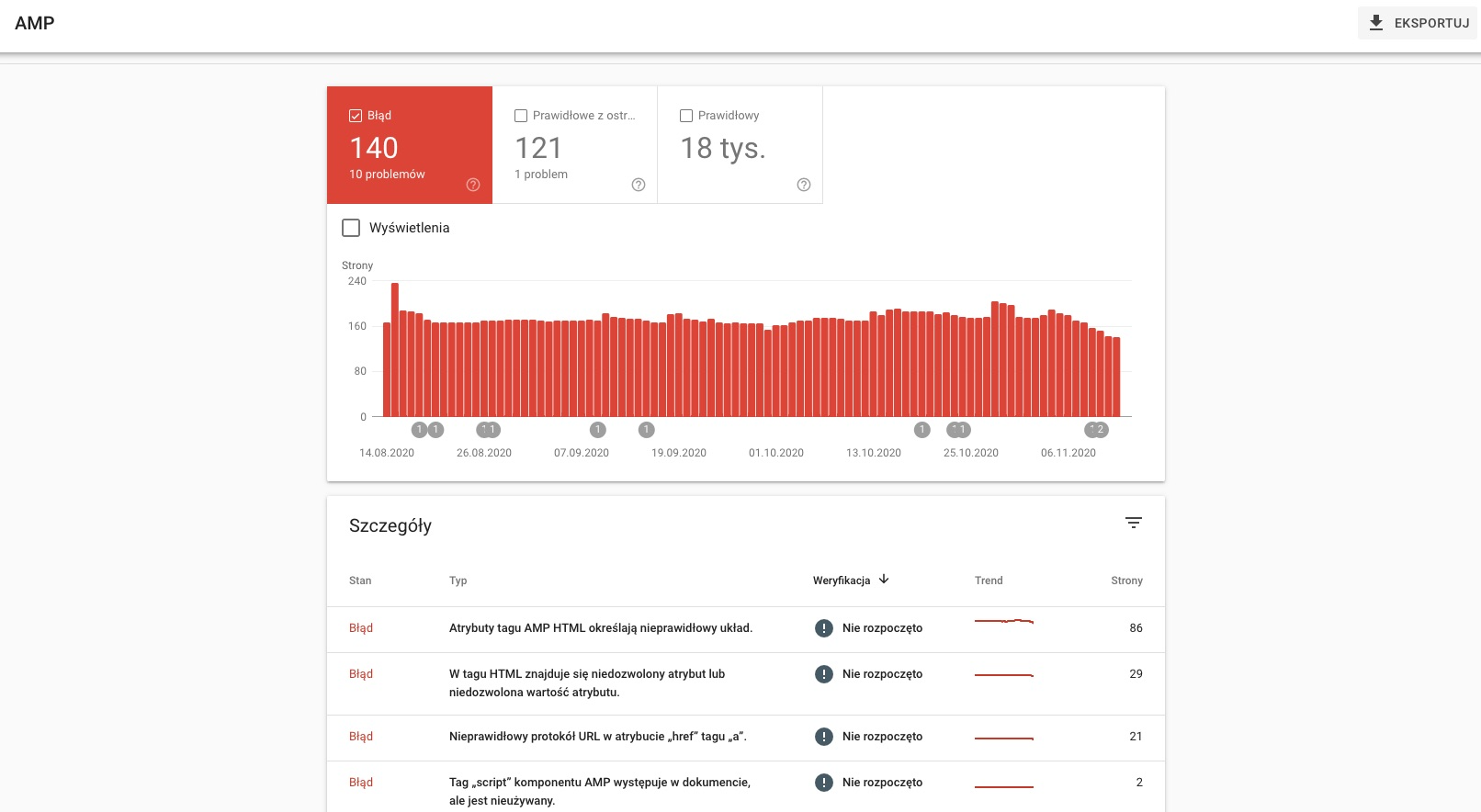

AMP

Raport AMP przedstawia informacje dotyczące wersji AMP witryny (szybsza i lżejsza wersja), o ile takowa jest wdrożona.

Analogicznie jak w raportach, które omawialiśmy wyżej, wszystkie podstrony są podzielone na kategorie:

- Błąd

- Prawidłowe z ostrzeżeniami

- Prawidłowe

Pod wykresem, który przedstawia rozkład URLi w danej kategorii w czasie, widzimy z kolei konkretne problemy i liczbę stron, których dotyczą.

Nie będziemy tu zagłębiać się w poszczególne typy błędów, ponieważ jest to kwestia ściśle związana ze specyfikacją AMP.

Do analizowania problemów z AMP przyda się z pewnością google’owy tester AMP: https://search.google.com/test/amp

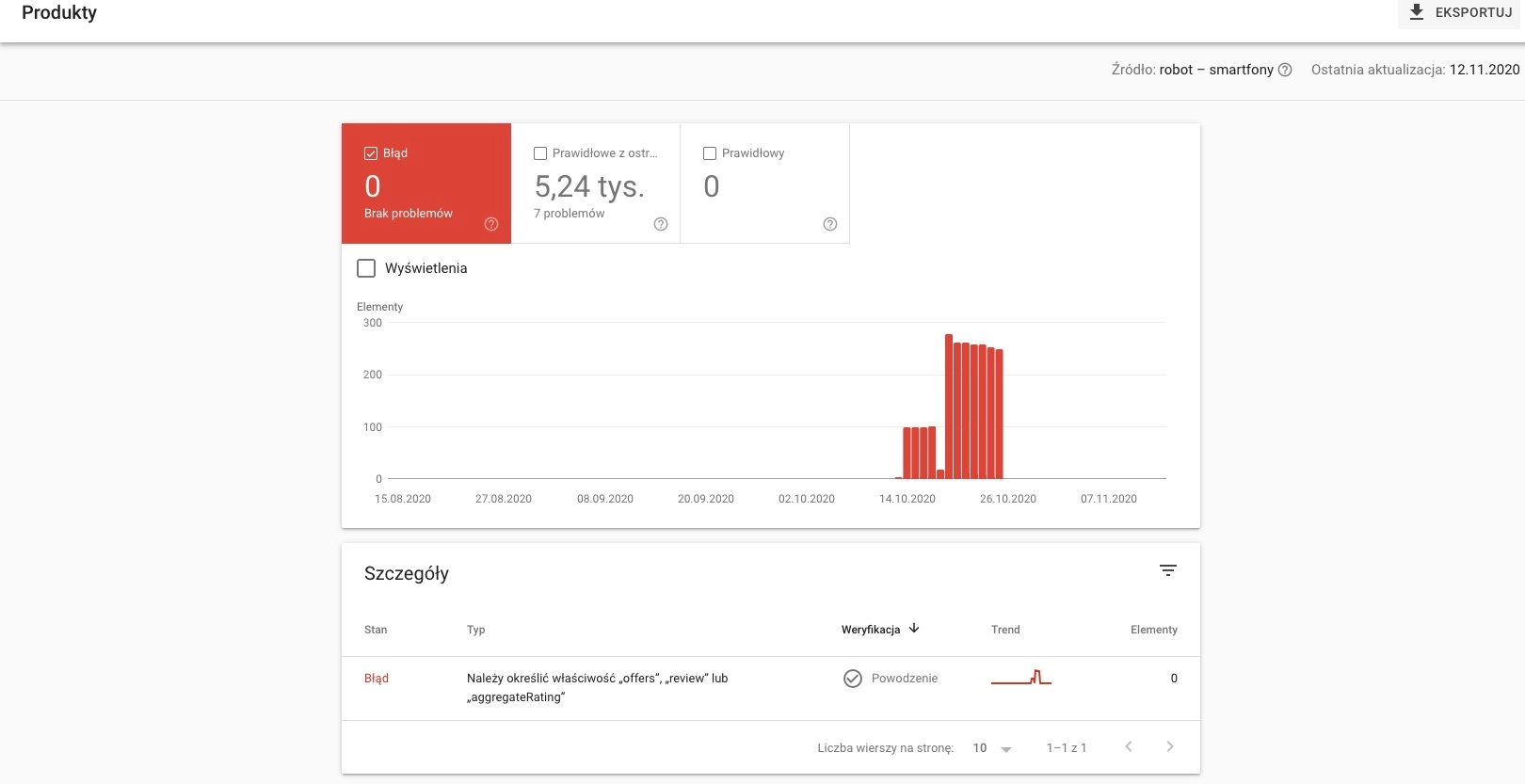

Raporty dotyczące danych strukturalnych

Pozostałe raporty w sekcji ulepszeń dotyczą danych strukturalnych wdrożonych w Twoim serwisie.

W zależności od wdrożonych elementów, możesz tu zobaczyć sekcję (w nawiasach odesłanie do opisu danego elementu z grafikami):

- Menu nawigacyjne: https://developers.google.com/search/docs/data-types/breadcrumb

- Wydarzenie: https://developers.google.com/search/docs/data-types/event

- FAQ: https://developers.google.com/search/docs/data-types/faqpage

- Przepis kulinarny: https://developers.google.com/search/docs/data-types/recipe

- Logo: https://developers.google.com/search/docs/data-types/logo

- Strona z pytaniami i odpowiedziami: https://developers.google.com/search/docs/data-types/qapage

- Fragment opinii: https://developers.google.com/search/docs/data-types/review-snippet

- Pole wyszukiwania linków do podstron: https://developers.google.com/search/docs/data-types/sitelinks-searchbox

- Video: https://developers.google.com/search/docs/data-types/video

Każdy z takich raportów ma podobną strukturę, adresy URL są podzielone na:

- Prawidłowe (mają wdrożone prawidłowo wybrane dane strukturalne)

- Prawidłowe, z ostrzeżeniami (występują błędy w implementacji, ale nie są one krytyczne)

- Zawierające błędy

Przykładowy raport prezentujący błędy we wdrażaniu danych strukturalnych związanych z produktami:

Bezpieczeństwo i ręczne działania

W tej grupie zebrano 2 raporty: ręczne działania oraz problemy dotyczące bezpieczeństwa.

Ręczne działania

W przypadku nałożenia przez Google kar znajdziesz powiadomienie w tym miejscu.

Zdarza się to obecnie już dość rzadko, ponieważ algorytmy Google działają w czasie rzeczywistym. Oznacza to, że w większości przypadków działania mocno naginające zasady wyszukiwarki skutkują obniżeniem pozycji w wynikach wyszukiwania.

Niemniej jednak z pewnością warto tu zajrzeć, szczególnie na początku pracy nad daną witryną.

Potencjalnie jednak witryna może otrzymać karę za:

- Spam tworzony przez użytkowników – najczęściej zdarza się to w przypadku niezabezpieczonych for internetowych

- Nienaturalne linki do Twojej witryny – wątpliwej jakości odnośniki pozyskiwane masowo

- Czysty spam – niskiej jakości treści utworzone w sposób automatyczny (np. korzystając z synonimów) lub skopiowane w całości z innych witryn

- Ukryty tekst lub upychanie słów kluczowych – tzw. cloaking, czyli prezentowanie innej treści dla robotów, a innej dla użytkowników, najczęściej w celu większego nasycenia strony słowami kluczowymi

Problemy dotyczące bezpieczeństwa

Raport zbiera informacje o incydentach, które mogą świadczyć o problemach z bezpieczeństwem Twojej witryny. Na Twojej stronie pojawiły się “podejrzane” treści, więc warto szybko zdiagnozować potencjalne problemy.

Sytuacja taka ma miejsce najczęściej w wyniku braku aktualizacji skryptu CMS, wykryciu dziur w wykorzystywanych wtyczkach, które dały możliwość niepowołanego dostępu do witryny. Poszukiwania potencjalnych przyczyn zacznij właśnie od tego.

Możliwe problemy, które mogą być wykryte i odnotowane w GSC to:

- Atak hakera: złośliwe oprogramowanie

- Atak hakerów: wstrzyknięty kod

- Atak hakerów: wstrzyknięta zawartość

- Atak hakerów: wstrzyknięty URL

- Strony wprowadzające w błąd

- Umieszczone zasoby wprowadzające w błąd

- Szkodliwe pliki do pobrania

- Linki do szkodliwych plików do pobrania

- Niejasne płatności za usługi mobilne

- Nietypowe pliki do pobrania

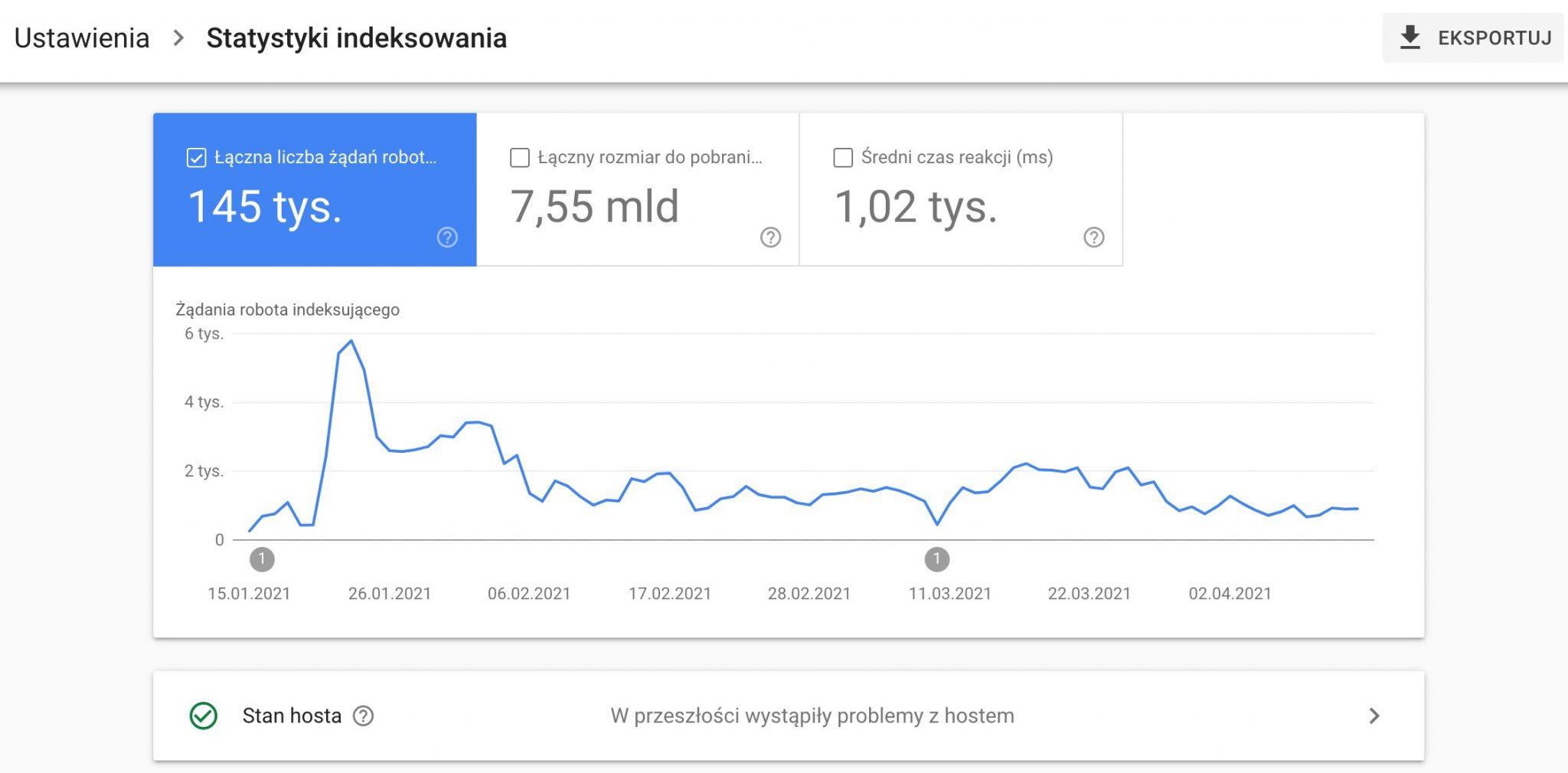

Statystyki indeksowania

Wprowadzony w 2020 roku raport, który umożliwia uproszczoną analizę logów z wizyt Googlebota.

Analizy logów są bardzo przydatne szczególnie w dużych serwisach, gdzie podstrony liczone są w setkach tysięcy i więcej.

Raport jest nieco schowany, by do niego wejść trzeba przejść do ustawień usługi i wybrać opcję Statystyki indeksowania.

Jest to spore ułatwienie dla specjalistów, ponieważ do tej pory, by taką analizę przeprowadzić, potrzebne było zebranie takich logów, ich obróbka w zewnętrznych narzędziach i dalsza analiza. W GSC dostajemy podsumowanie danych na tacy.

W podsumowaniu raportu zobaczymy:

- Łączną liczbę żądań

- Łączny rozmiar plików do pobrania

- Średni czas reakcji w ms

Pierwsze dwie dane mają wartość raczej informacyjną i są ściśle związane z wielkością serwisu. Warto obserwować przede wszystkim czy nie występują nagłe spadki tych 2 parametrów, bo może to świadczyć o problemach z crawlowaniem serwsu przez roboty.

Średni czas reakcji w ms – obliczany dla wszystkich zasobów w Twojej witrynie (a więc zarówno HTML, jak i grafiki). Wartości poniżej 300-400 ms będą już naprawdę super!

Poniżej znajdziemy podsumowanie żądań indeksowania według.

Krótko opisałem, jak interpretować każde z wyników.

Odpowiedzi:

- 200 – strona ładuje się prawidłowo, w idealnej sytuacji mamy 100% tego typu odpowiedzi

- 301 – przekierowana, jeśli przekraczają kilka %, warto je namierzyć i poprawić linkowanie wewnętrzne w serwisie

- 404 – podobnie, przy udziale ponad kilka % warto przekierować najczęstsze 404 na inne URL-e

- Pozostałe kody – te powinny pojawiać się jak najrzadziej, gdyż świadczą o nieprawidłowej pracy serwera (kody zaczynające się od 500) lub problemach z dostępem do plików dla robota Google (np. 403)

Typu pliku: HTML, JS, CSS, inne typy

Struktura żądań w takim podziale pokazuje po prostu, jak często roboty pobierają plik określonego typu.

Przeznaczenie:

- Odświeżenie – robot ma już zaindeksowany dany adres URL, ale sprawdza, czy wystąpiły zmiany

- Wykrywalność – pierwsza wizyta robota na danym adresie URL

Typ Googlebota:

- Wersja na komputery – roboty odczytujące witrynę w wersji desktop

- Smartfony – roboty czytające wersję mobilną

- AdsBot – roboty związane z Google Ads

- Grafika – indeksujące grafiki

- Ładowanie zasobu strony – specjalny rodzaj żądania, dotyczący załadowania dodatkowych elementów (głównie JS)

Podsumowując, w tym raporcie warto sprawdzać przede wszystkim:

- Czy nie występują nagłe spadki liczby żądań Googlebota

- Czy nie wzrasta średni czas reakcji

- Czy nie ma zbyt dużego udziału kodów innych niż 200

Starsze narzędzia i raporty

Google Search Console przeszło znaczące odświeżenie w 2018. Raporty były przenoszone stopniowo do nowego layoutu i na nowe mechanizmy. Część z nich dostępna jest jednak w starszej wersji.

Raporty te zostały wyszczególnione w sekcji Starsze narzędzia.

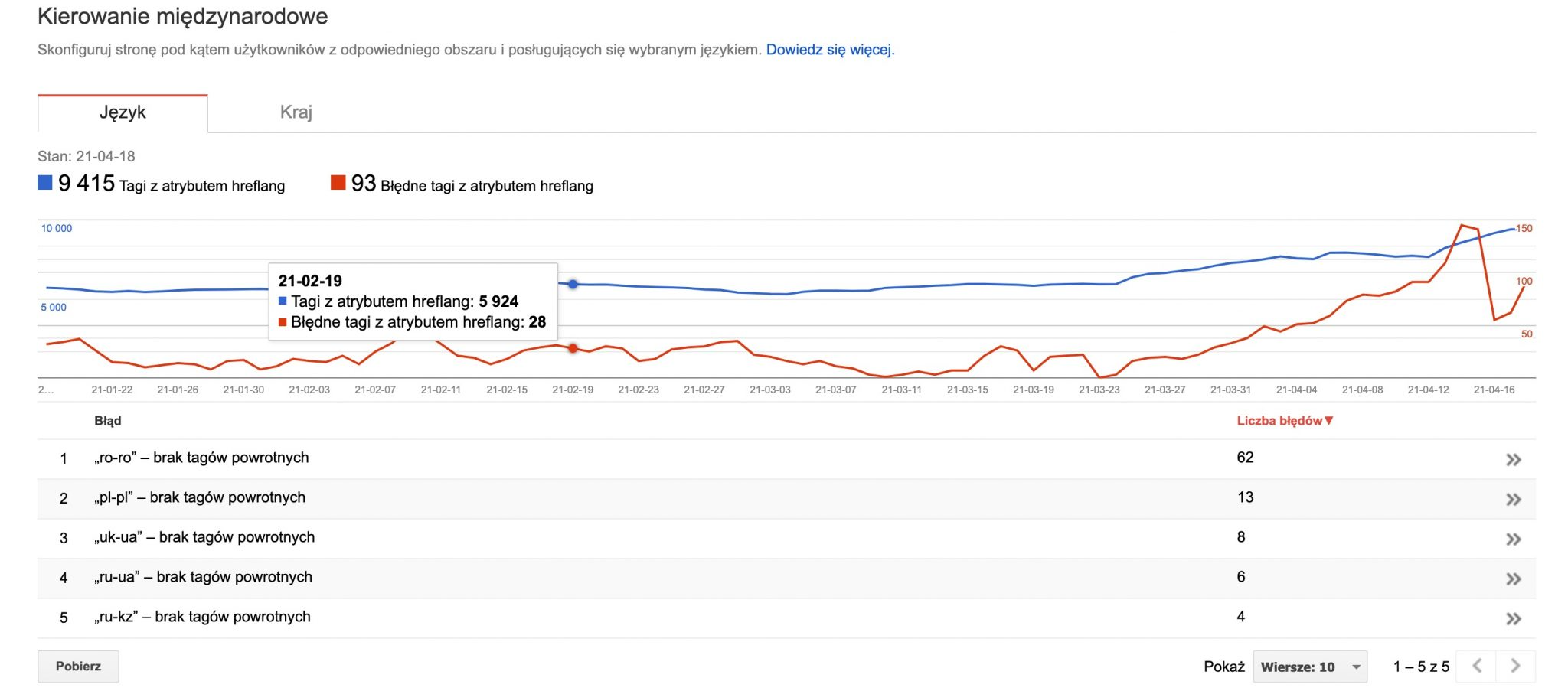

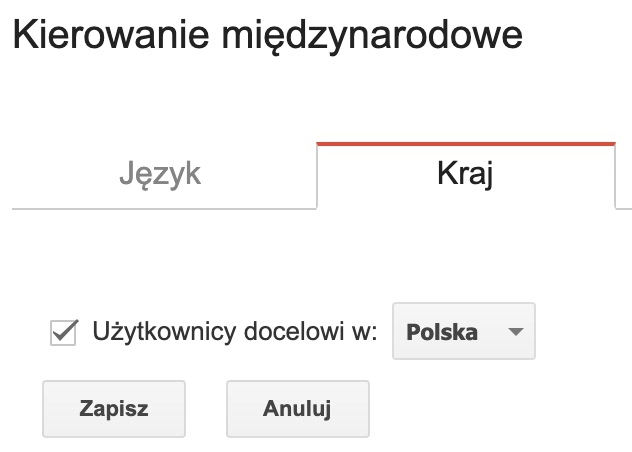

Kierowanie międzynarodowe

Narzędzie przeznaczone dla witryn wielojęzycznych, służące do zarządzania kierowaniem wersji językowych na odpowiednie kraje.

Mamy tu 2 zakładki

- Język

- Kraj

Język

Zbiera informacje dotyczące znaczników hreflang (wskazujące inne wersje językowe tej samej strony):

- ile stron ze znacznikiem hreflang zostało wykrytych przez roboty

- ile błędów związanych z hreflang mamy w serwisie (np. jak na screenie brak tagów powrotnych, tzn. wersja A linkuje do wersji B, ale brak takiego linkowania w drugą stronę – powrotnego)

Kraj

W tym miejscu sprawdzimy ustawienie kraju docelowego. Ustawienie takiego kraju ma sens, jeśli mamy domenę krajową (.pl, .de. co.uk) i chcemy pozycjonować się głównie w tym jednym kraju.

Wiadomości

Zebrane w jednym miejscu komunikaty związane z daną domeną:

- nowe problemy z indeksacją

- nowe problemy z optymalizacją pod mobile

- raporty miesięczne podsumowujące skuteczność

Te same wiadomości aktualnie znajdziesz pod ikonką dzwoneczka w prawym górnym rogu panelu GSC.

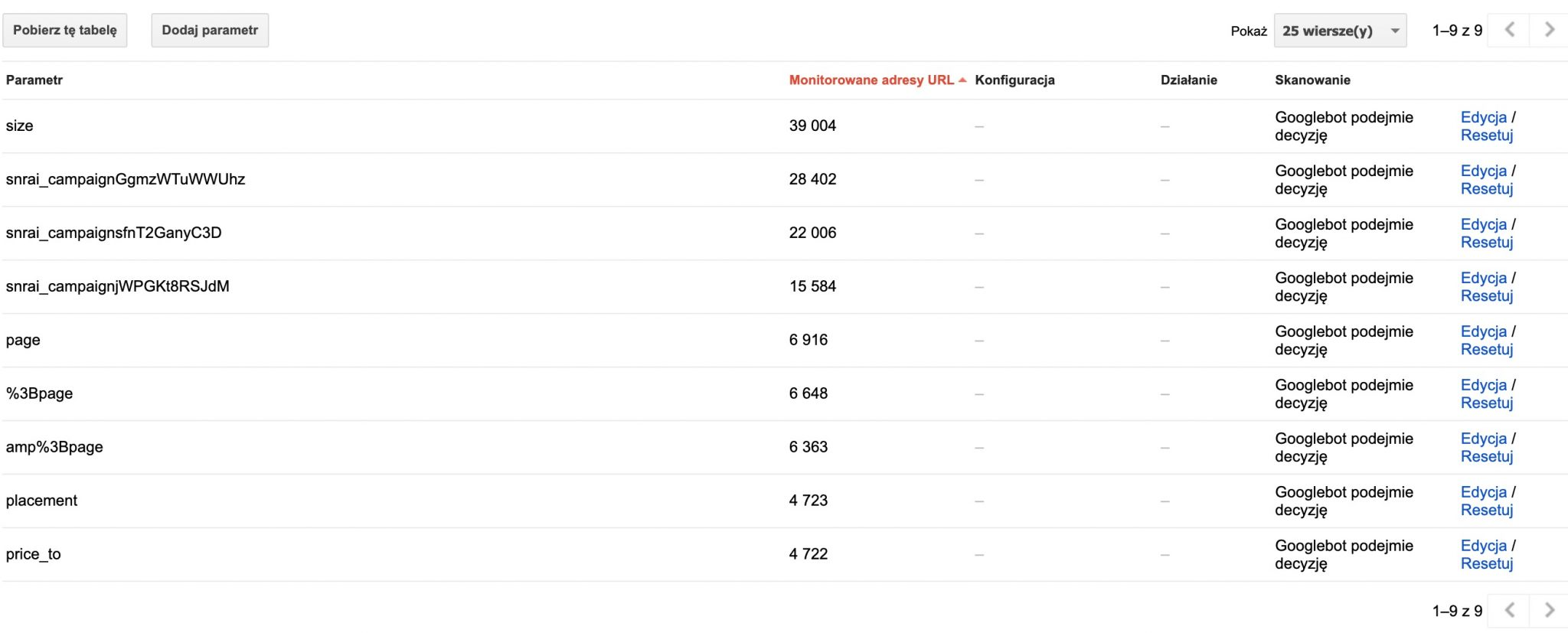

Parametry w adresach URL

Narzędzie do zarządzania parametrami w adresach URL będzie szczególnie przydatne dla sklepów internetowych. To w nich najczęściej używa się parametrów w adresach URL do sortowania, zawężania i filtrowania przeglądanego zakresu produktów.

Przykładowe adresy URl z parametrami mogą wyglądać np. tak:

https://skleprowerowy.pl/rowery-mtb?rozmiar=28

https://sklepmodoowy.pl/sukienki?material=jeans

https://sklepkuchenny.pl/czajniki?cena_max=100&kolor=bialy

Liczba możliwych kombinacji jest zwykle bardzo duża i dla skutecznego SEO w e-commerce niezbędne jest odpowiednie zarządzenie indeksacją takich adresów URL.

Co prawda służą do tego głównie znaczniki rel canonical, jednak nie zaszkodzi dodatkowo skonfigurować obsługę adresów URL z parametrami w GSC.

Przykładowe dane, pochodzące z sklepu internetowego wyglądają w ten sposób:

Dane, które tu widzimy to:

- Parametr – dane zebrane są dla każdego z parametrów osobno

- Monitorowane adresy URL – liczba wykrytych adresów URL z takim parametrem

- Konfiguracja – data konfiguracji danego parametru

- Działanie – zdefiniowana przez nas rola tego parametru

- Skanowanie – informacja, czy dany adres URL ma być skanowany

Dla każdego z parametrów określamy konfigurację klikając Edycja, pojawi się wtedy pole konfiguracji, gdzie musimy wybrać odpowiednie opcje odpowiadając na pytania.

Czy ten parametr powoduje zmianę zawartości strony widocznej dla użytkownika?

Nie, nie ma wpływu na zawartość strony (np. służy do monitorowania) – tę opcję wybierzmy dla parametrów takich jak identyfikator sesji czy oznaczenie kampanii (np. UTMy).

Tak: zmienia, porządkuje lub zawęża zawartość strony – jak sama nazwa mówi, w taki sposób konfigurujemy parametry, które służą do sortowania, filtrowania, wyboru parametrów

Jaki wpływ na zawartość strony ma ten parametr? (jeśli w poprzednim pytaniu zaznaczyliśmy tak)

Do wyboru mamy takie role parametrów:

- Sortuje

- Zawęża – wybieramy w przypadku filtrów

- Określa – np. dzieli na kategorie

- Tłumaczy

- Dzieli na strony

- Inne – np. wyszukiwanie

Które adresy URL z tym parametrem mają być indeksowane przez Googlebota?

Ostatni etap konfiguracji to wskazanie, czy adresy URL z tym parametrem powinny być indeksowane:

- Googlebot podejmie decyzję

- Wszystkie adresy URL

- Tylko adresy URL z wartością – możemy tu wydzielić konkretną podgrupę, która jako jedyna ma być indeksowana

- Żadne adresy URL

Korzystając z tego narzędzia trzeba pamiętać, że są to jednak nasze zalecenia dla robotów, które niekoniecznie będą respektowane.

Nie warto więc polegać jedynie na konfiguracji parametrów w tym miejscu, ale też odpowiednio wdrożyć znaczniki rel canonical.

Disavow Tool

Kolejne z narzędzi nie jest dostępne z panelu GSC (zapewne nieprzypadkowo. Żeby go użyć musimy wejść pod adres: https://search.google.com/search-console/disavow-links i wybrać odpowednią domenę)

Uwaga!

Disavow Tool, czyli narzędzie do zrzekania się linków przychodzących jest przeznaczone dla zaawansowanych, a jego nieprawidłowe użycie może mieć poważne konsekwencje w postaci utraty ruchu organicznego.

Historia narzędzia

Narzędzie do zrzekania się linków powstało jeszcze w czasach słynnego algorytmu Google Pingwin, którego zadaniem było wychwytywanie nienaturalnych linków.

Jeśli Google wykryło dużą ilość podejrzanych linków, otrzymywało się karę w postaci obniżenia pozycji. Żeby tej kary się pozbyć webmaster musiał “wyspowiadać się” i udokumentować swoje starania dla poprawy sytuacji (np. udokumentować prośby do właścicieli witryn o zdjęcie szkodliwych linków). Był to proces czasochłonny, ponieważ odpowiedź na taki wniosek od Google mogła trwać nawet kilka tygodni.

Z pomocą przyszło więc narzędzie do samodzielnego zgłoszenia takich szkodliwych linków, których chcemy się pozbyć.

Czy narzędzie to ma jeszcze zastosowanie w czasach, gdy Google chwali się, że jej AI potrafi samodzielnie rozpoznać szkodliwe linki?

Zdania na ten temat są podzielone, wielu seowców traktuje korzystanie z Disavow Tool jako “samodonos”, a część nadal profilaktycznie z niego korzysta, szczególnie po otrzymaniu darmowych spamerskich linków do swojej witryny, o które nie prosili. Ja należę do tej drugiej grupy.

Jak zgłosić zrzeczenie się szkodliwych linków?

W pierwszej kolejności konieczne będzie przygotowanie listy linków, których chcemy się zrzec. Mamy tu 2 opcję do wyboru: zgłoszenie jednego konkretnego linka lub całej domeny.

W zależności od wybranej opcji w pliku tekstowym zapiszemy:

https://chinskispam.cn/spamlinks

lub

domain:chinskispam.cn

Tak przygotowany plik należy zapisać w formacie .txt oraz formatowaniu UTF-8.

Dokładniejsze wytyczne znajdziesz pod adresem: https://support.google.com/webmasters/answer/2648487#file_format

Uwaga!

Warto sprawdzić, czy taki plik nie był już wcześniej przygotowywany dla danej domeny. Jeśli tak, to należy rozszerzyć już istniejący plik, a nie dodawać nowy. Podmiana pliku spowoduje, że cofniemy zrzeczenie się wcześniej zgłoszonych szkodliwych linków.

Zgłoszone linki będą uwzględnione po około kilku tygodniach.

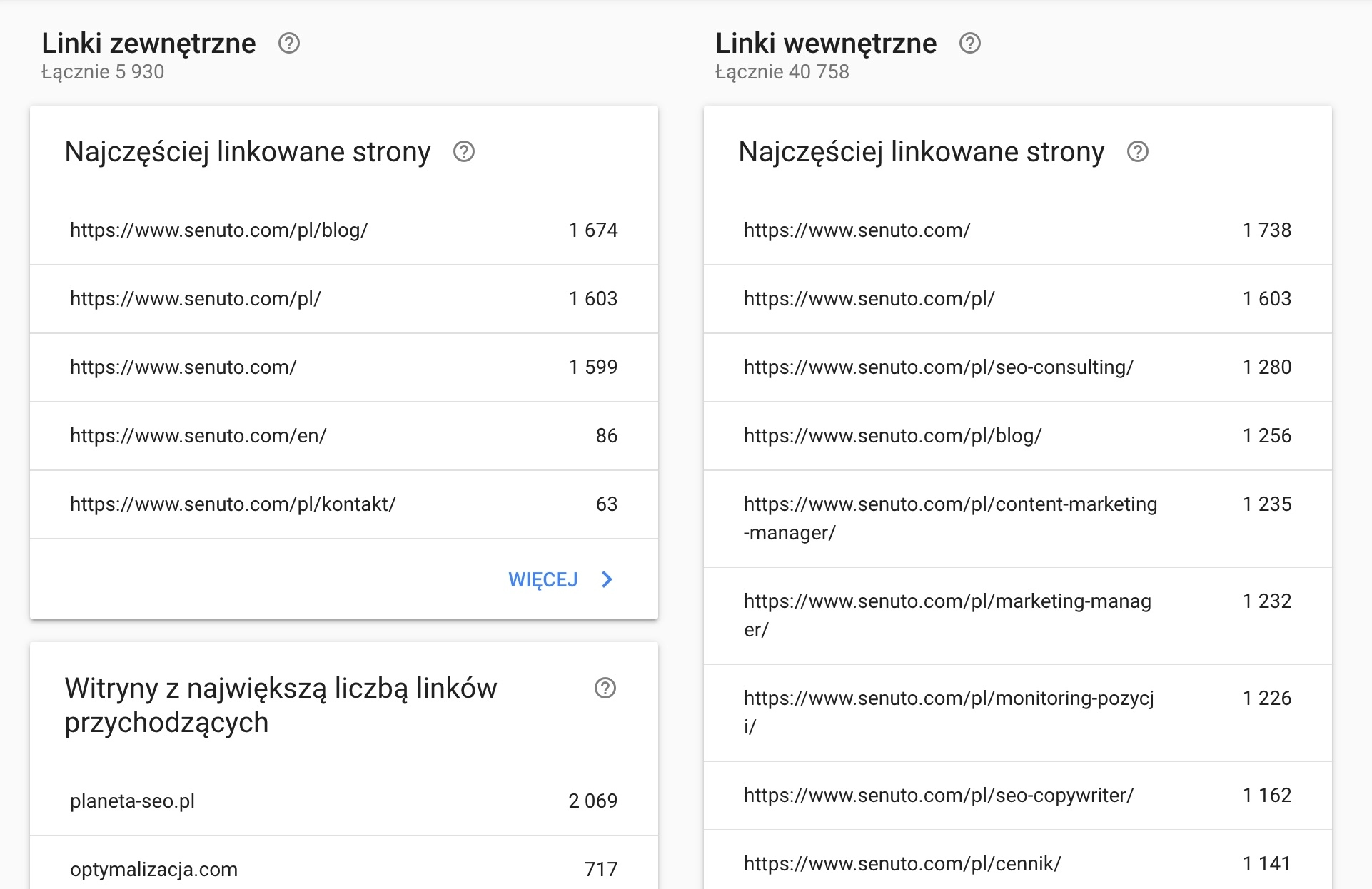

Linki

Ostatnia z grup raportów skupia się na linkach: zewnętrznych oraz wewnętrznych.

Do analizy mamy 3 raporty:

- Linki zewnętrzne / Najczęściej linkowane strony – które z podstron mają najwięcej linków przychodzących z innych witryn, po kliknięciu w adres URL zobaczymy też informację z jakich domen są linki do tej podstrony

- Linki zewnętrzne / Witryny z największą liczbą linków przychodzących – lista domen, które linkują do naszej

- Linki zewnętrzne / Tekst z największą liczbą linków przychodzących – lista anchor tekstów, które najczęściej występują w linkach przychodzących

- Linki wewnętrzne / Najczęściej linkowane strony – wewnętrzne strony, posortowane wg najczęściej linkowanych wewnętrznie

Trzeba mieć na uwadze, że ten raport nie jest najmocniejszą stroną GSC i porównując dane z innymi narzędziami możemy dopatrzeć się sporych rozbieżności.

Analizowanie danych o linkach w GSC może być dobrym rozwiązaniem dla właścicieli małych witryn, gdzie nie ma potrzeby zakupu wyspecjalizowanych narzędzi.

Dane z GSC będą też dobre do przeprowadzenia głębszej analizy, gdy zbieramy dane z wielu narzędzi by mieć pełny obraz sytuacji.

Ustawienia

W tym miejscu masz możliwość zarządzania:

- Użytkownikami i ich uprawnieniami (opisane na początku artykułu)

- Powiązaniami z innymi usługami (Google Analytics)

- Zmianą adresu witryny – przydatne narzędzie w przypadku migracji na inną domenę, dla usprawnienia procesu takie przeniesienie warto zgłosić w GSC

Sprawdzisz też:

- Jaki robot indeksujący skanuje Twoją witrynę (dedykowany na smartfony lub na komputery) i kiedy nastąpiło ewentualne przejście

- Kiedy dodano usługę do konta

Podsumowanie

Google Search Console jest z pewnością najważniejszym narzędziem w codziennej pracy specjalisty SEO. Warto dokładnie znać wszystkie jego funkcje, bo przeważnie w tym miejscu będziemy zaczynać. Istotną przewagą GSC nad innymi narzędziami są dane bezpośrednio od Google. W ostatnich latach można obserwować zmianę podejścia Google do rozwoju narzędzia. Wcześniej raczej ciężko było o nowości i nowe funkcje, obecnie pojawiają się one prawie każdego miesiąca. Oby tak dalej!

Karol Soja

Karol Soja